May

13

El “universo” de las Partículas II

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (0)

Comments (0)

Estamos hablando de las partículas y no podemos dejar a un lado el tema del movimiento rotatorio de las mismas. Usualmente se ve cómo la partícula gira sobre su eje, a semejanza de un trompo, o como la Tierra o el Sol, o nuestra galaxia o, si se me permite decirlo, como el propio universo. En 1.925, los físicos holandeses George Eugene Uhlenbeck y Samuel Abraham Goudsmit aludieron por primera vez a esa rotación de las partículas. Éstas, al girar, generan un minúsculo campo electromagnético; tales campos han sido objeto de medidas y exploraciones, principalmente por parte del físico alemán Otto Stern y el físico norteamericano Isaac Rabi, quienes recibieron los premios Nobel de Física en 1.943 y 1.944 respectivamente, por sus trabajos sobre dicho fenómeno.

Esas partículas (al igual que el protón, el neutrón y el electrón), que poseen espines que pueden medirse en números mitad, se consideran según un sistema de reglas elaboradas independientemente, en 1.926, por Fermi y Dirac; por ello, se las llama y conoce como estadísticas Fermi-dirac. Las partículas que obedecen a las mismas se denominan fermiones, por lo cual el protón, el electrón y el neutrón son todos fermiones.

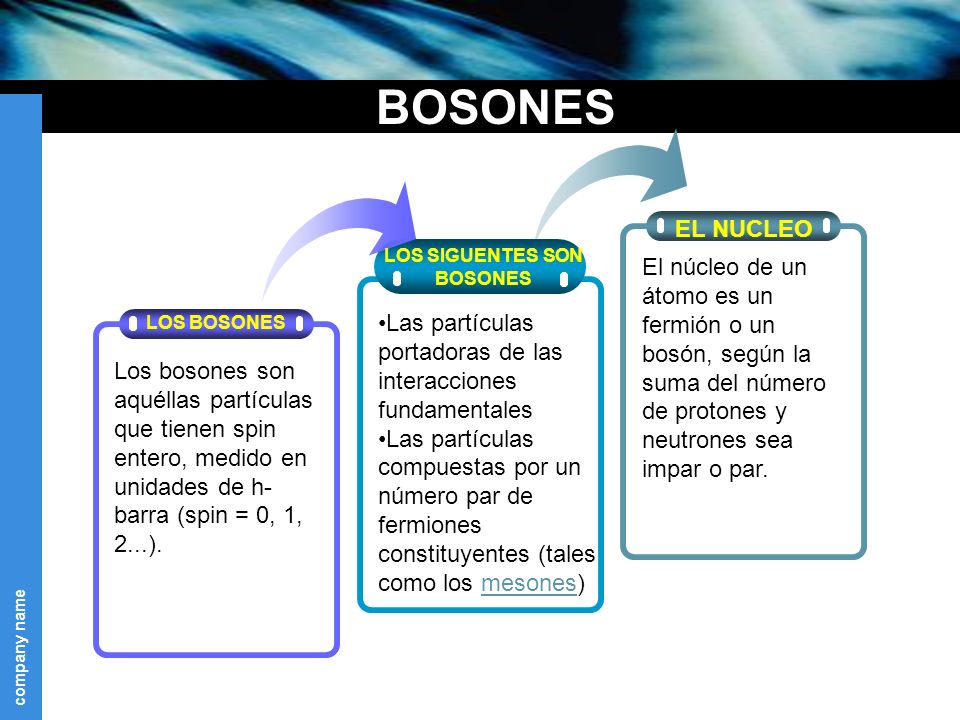

Hay también partículas cuya rotación, al duplicarse, resulta igual a un número par. Para manipular sus energías hay otra serie de reglas, ideadas por Einstein y el físico indio S. N. Bose. Las partículas que se adaptan a la estadística Bose-Einstein son bosones, como por ejemplo la partícula alfa.

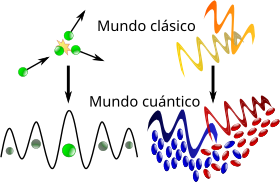

Las reglas de la mecánica cuántica tienen que ser aplicadas si queremos describir estadísticamente un sistema de partículas que obedece a reglas de esta teoría en vez de los de la mecánica clásica. En estadística cuántica, los estados de energía se considera que están cuantizados. La estadística de Bose-Einstein se aplica si cualquier número de partículas puede ocupar un estado cuántico dad. Dichas partículas (como dije antes) son bosones, que tienden a juntarse.

Los bosones tienen un momento angular nh/2π, donde n es 0 o un entero, y h es la constante de Planck. Para bosones idénticos, la función de ondas es siempre simétrica. Si sólo una partícula puede ocupar un estado cuántico, tenemos que aplicar la estadística Fermi-Dirac y las partículas (como también antes dije) son los fermiones que tienen momento angular (n + ½)h / 2π y cualquier función de ondas de fermiones idénticos es siempre antisimétrica. La relación entre el espín y la estadística de las partículas está demostrada por el teorema espín-estadística.

En un espacio de dos dimensiones es posible que haya partículas (o cuasipartículas) con estadística intermedia entre bosones y fermiones. Estas partículas se conocen con el nombre de aniones; para aniones idénticos, la función de ondas no es simétrica (un cambio de fase de +1) o antisimétrica (un cambio de fase de -1), sino que interpola continuamente entre +1 y -1. Los aniones pueden ser importantes en el análisis del efecto Hall cuántico fraccional y han sido sugeridos como un mecanismo para la superconductividad de alta temperatura.

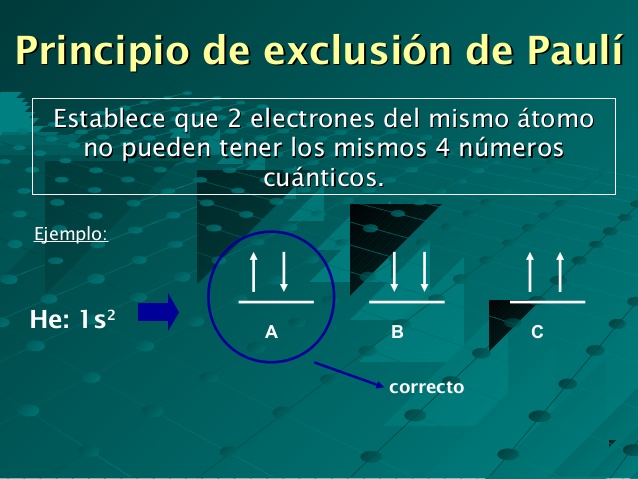

Debido al principio de exclusión de Pauli, es imposible que dos fermiones ocupen el mismo estado cuántico (al contrario de lo que ocurre con los bosones). La condensación Bose-Einstein es de importancia fundamental para explicar el fenómeno de la superfluidez. A temperaturas muy bajas (del orden de 2×10-7K) se puede formar un condensado de Bose-Einstein, en el que varios miles de átomos dorman una única entidad (un superátomo). Este efecto ha sido observado con átomos de rubidio y litio. Como ha habréis podido suponer, la condensación Bose-Einstein es llamada así en honor al físico Satyendra Nath Bose (1.894 – 1.974) y a Albert Einstein. Así que, el principio de exclusión de Pauli tiene aplicación no sólo a los electrones, sino también a los fermiones; pero no a los bosones.

Si nos fijamos en todo lo que estamos hablando aquí, es fácil comprender cómo forma un campo magnético la partícula cargada que gira, pero ya no resulta tan fácil saber por qué ha de hacer lo mismo un neutrón descargado. Lo cierto es que cuando un rayo de neutrones incide sobre un hierro magnetizado, no se comporta de la misma forma que lo haría si el hierro no estuviese magnetizado. El magnetismo del neutrón sigue siendo un misterio; los físicos sospechan que contiene cargas positivas y negativas equivalente a cero, aunque por alguna razón desconocida, logran crear un campo magnético cuando gira la partícula.

Particularmente creo que, si el neutrón tiene masa, si la masa es energía (E = mc2), y si la energía es electricidad y magnetismo (según Maxwell), el magnetismo del neutrón no es tan extraño, sino que es un aspecto de lo que en realidad es materia. La materia es la luz, la energía, el magnetismo, en definitiva, la fuerza que reina en el universo y que está presente de una u otra forma en todas partes (aunque no podamos verla).

Sea como fuere, la rotación del neutrón nos da la respuesta a esas preguntas:

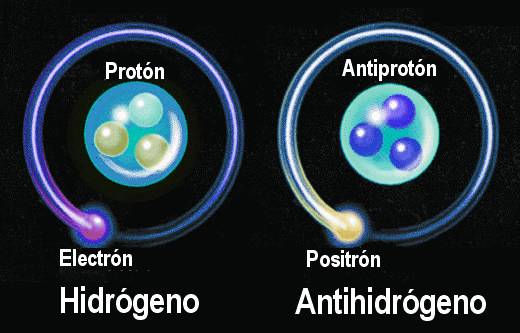

¿Qué es el antineutrón? Pues, simplemente, un neutrón cuyo movimiento rotatorio se ha invertido; su polo sur magnético, por decirlo así, está arriba y no abajo. En realidad, el protón y el antiprotón, el electrón y el positrón, muestran exactamente el mismo fenómeno de los polos invertidos.

Es indudable que las antipartículas pueden combinarse para formar la antimateria, de la misma forma que las partículas corrientes forman la materia ordinaria.

La primera demostración efectiva de antimateria se tuvo en Brookhaven en 1.965, donde fue bombardeado un blanco de berilio con 7 protones BeV y se produjeron combinaciones de antiprotones y antineutrones, o sea, un antideuterón. Desde entonces se ha producido el antihelio 3, y no cabe duda de que se podría crear otros antinúcleos más complicados aún si se abordara el problema con más interés.

Pero, ¿existe en realidad la antimateria? ¿Hay masas de antimateria en el universo? Si las hubiera, no revelarían su presencia a cierta distancia. Sus efectos gravitatorios y la luz que produjeran serían idénticos a los de la materia corriente. Sin embargo, cuando se encontrasen las masas de las distintas materias, deberían ser claramente perceptibles las reacciones masivas del aniquilamiento mutuo resultante del encuentro. Así pues, los astrónomos observan especulativamente las galaxias, para tratar de encontrar alguna actividad inusual que delate interacciones materia-antimateria.

No parece que dichas observaciones fuesen un éxito. ¿Es posible que el universo esté formado casi enteramente por materia, con muy poca o ninguna antimateria? Y si es así, ¿por qué? Dado que la materia y la antimateria son equivalente en todos los aspectos, excepto en su oposición electromagnética, cualquier fuerza que crease una originaría la otra, y el universo debería estar compuesto de iguales cantidades de la una y de la otra.

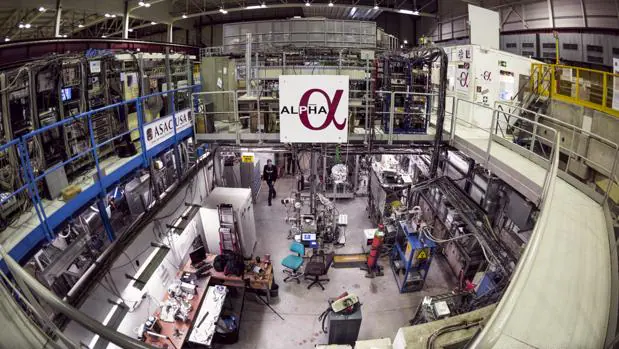

Aquí detectaron lograron encontrar la anti-materia por primera vez

Este es el dilema. La teoría nos dice que debería haber allí antimateria, pero las observaciones lo niegan, no lo respaldan. ¿Es la observación la que falla? ¿Y qué ocurre con los núcleos de las galaxias activas, e incluso más aún, con los quásares? ¿Deberían ser estos fenómenos energéticos el resultado de una aniquilación materia-antimateria? ¡No creo! Ni siquiera ese aniquilamiento parece ser suficiente, y los astrónomos prefieren aceptar la noción de colapso gravitatorio y fenómenos de agujeros negros, como el único mecanismo conocido para producir la energía requerida.

Con esto de la antimateria me ocurre igual que con el hecho, algunas veces planteado, de la composición de la materia en lugares lejanos del universo. “Ha caído una nave extraterrestre y nuestros científicos han comprobado que está hecha de un material desconocido, casi indestructible”. Este comentario se ha podido oír en alguna película de ciencia ficción. Podría ser verdad (un material desconocido), sin embargo, no porque la nave esté construida por una materia distinta, sino porque la aleación es distinta y más avanzada a partir de los materiales conocidos del universo. En cualquier parte del universo, por muy lejana que pueda estar, rigen los mismos principios y las mismas fuerzas: la materia y la energía son las mismas en cualquier parte. Lo único que puede diferir es la forma en que se utilice, el tratamiento que se le pueda dar, y sobre todo, el poseer el conocimiento y la tecnología necesarios para poder obtener el máximo resultado de las propiedades que dicha materia encierra, porque, en última instancia, ¿es en verdad inerte la materia?

El experimento Alpha para el estudio de la antimateria – Maximilien Brice / CERN

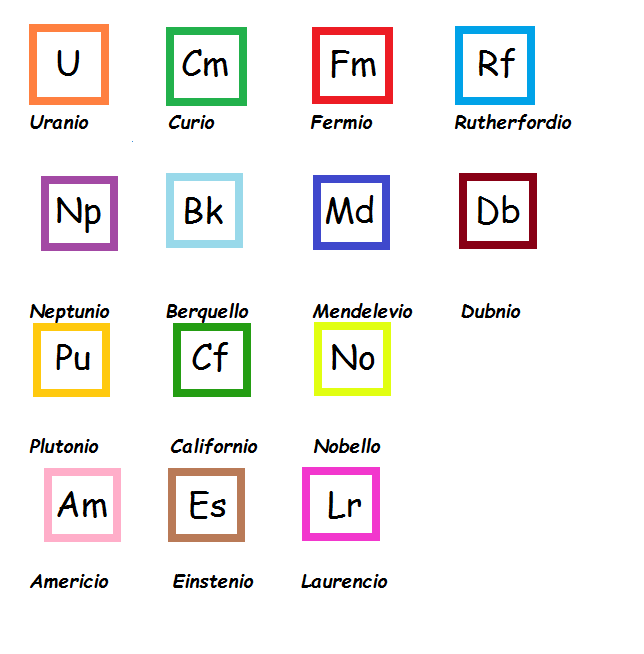

Todo lo que podemos ver en el Universo, sin excepción, está hecho de materia. Tiene y encierra tantos misterios la materia que estamos aún a años luz de saber y conocer sobre su verdadera naturaleza. Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos, pero que tampoco sabemos, en realidad, a qué son debidas. Sí, sabemos ponerles etiquetas como la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio, y con mayor frecuencia, en los elementos que conocemos como transuránidos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de su ruptura, sobrepasando a la emisión de partículas alfa. ¡Parece que la materia está viva! Son muchas las cosas que desconocemos, y nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o el antineutrón), y por lo tanto, han sido denominados leptones (de la voz griega leptos, que dignifica “delgado”).

Aunque el electrón fue descubierto en 1.897 por el físico británico Joseph John Thomson (1.856 – 1.940), el problema de su estructura, si la hay, aún no está resuelto. Conocemos su masa y su carga negativa que responden a 9’1093897 (54) × 10-31 Kg la primera, y 1’60217733 (49) × 10-19 culombios la segunda, y también su radio clásico r0 igual a e2/(mc2) = 2’82 × 10-13 cm. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea la que fuese (sabemos cómo actúa y cómo medir sus propiedades, pero aún no sabemos qué es), que tenga asociada un mínimo de masa.

Lo cierto es que el electrón es una maravilla en sí mismo. El universo no sería como lo conocemos si el electrón fuese distinto a como es; bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora.

Muchos granos de arena conforman la inmensa playa

¡No por pequeño se el insignificante!

Recordémoslo, todo lo grande está hecho de cosas pequeñas. En realidad, existen partículas que no tiene asociada ninguna masa en absoluto, es decir, ninguna masa en reposo. Por ejemplo, las ondas de luz y otras formas de radiación electromagnética se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones*). Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda, se denomina fotón, de la palabra griega que significa “luz”.

El fotón tiene una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma de que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este término se reserva para la familia formada por el electrón, el muón y la partícula tau, con sus correspondiente neutrinos: υe, υμ y υτ.

Existen razones teóricas para suponer que cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitaciones. Esas ondas pueden, así mismo, poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La forma gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón, y por tanto, ha de ser inimaginablemente difícil de detectar.

No será fácil detectar gravitones

De todos modos, el físico norteamericano Joseph Weber emprendió en 1.957 la formidable tarea de detectar el gravitón. Llegó a emplear un par de cilindros de aluminio de 153 cm de longitud y 66 de anchura, suspendidos de un cable en una cámara de vacío. Los gravitones (que serían detectados en forma de ondas) desplazarían levemente esos cilindros, y se empleó un sistema para detectar el desplazamiento que llegase a captar la cienbillonésima parte de un centímetro. Las débiles ondas de los gravitones, que proceden del espacio profundo, deberían chocar contra todo el planeta, y los cilindros separados por grandes distancias se verán afectados de forma simultánea. En 1.969, Weber anunció haber detectado los efectos de las ondas gravitacionales. Aquello produjo una enorme excitación, puesto que apoyaba una teoría particularmente importante (la teoría de Einstein de la relatividad general). Desgraciadamente, nunca se pudo comprobar mediante las pruebas realizadas por otros equipos de científicos que duplicaron el hallazgo de Weber.

En cualquier caso, no creo que a estas alturas alguien pueda dudar de la existencia de los gravitones, el bosón mediador de la fuerza gravitatoria. La masa del gravitón es 0, su carga es 0, y su espín es 2. Como el fotón, no tiene antipartícula; ellos mismos hacen las dos versiones.

emilio silvera

May

12

Velocidades inimaginables

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física Cuántica ~

Clasificado en Física Cuántica ~

Comments (3)

Comments (3)

En el centro del átomo se encuentra un pequeño grano compacto aproximadamente 100.000 veces más pequeño que el propio átomo: el núcleo atómico. Su masa, e incluso más aún su carga eléctrica, determinan las propiedades del átomo del cual forma parte. Debido a la solidez del núcleo parece que los átomos, que dan forma a nuestro mundo cotidiano, son intercambiables entre sí, e incluso cuando interaccionan entre ellos para formar sustancias químicas (los elementos). Pero el núcleo, a pesar de ser tan sólido, puede partirse. Si dos átomos chocan uno contra el otro con gran velocidad podría suceder que los núcleos llegaran a chocar entre sí y entonces, o bien se rompen en trozos, o se funden liberando en el proceso partículas subnucleares. La nueva física de la primera mitad del siglo XX estuvo dominada por los nuevos acertijos que estas partículas planteaban.

Pero tenemos la mecánica cuántica; ¿es que no es aplicable siempre?, ¿cuál es la dificultad? Desde luego, la mecánica cuántica es válida para las partículas subatómicas, pero hay más que eso. Las fuerzas con que estas partículas interaccionan y que mantienen el núcleo atómico unido son tan fuertes que las velocidades a las que tienen que moverse dentro y fuera del núcleo están cerca de la velocidad de la luz, c, que es de 299.792’458 Km/s. Cuando tratamos con velocidades tan altas se necesita una segunda modificación a las leyes de la física del siglo XIX; tenemos que contar con la teoría de la relatividadespecial de Einstein.

Esta teoría también fue el resultado de una publicación de Einstein de 1905. en esta teoría quedaron sentadas las bases de que el movimiento y el reposo son conceptos relativos, no son absolutos, como tampoco habrá un sistema de referencia absoluto con respecto al cual uno pueda medir la velocidad de la luz.

Pero había más cosas que tenían que ser relativas. En este teoría, la masa y la energía también dependen de la velocidad, como lo hacen la intensidad del campo eléctrico y del magnético. Einstein descubrió que la masa de una partícula es siempre proporcional a la energía que contienen, supuesto que se haya tenido en cuenta una gran cantidad de energía en reposo de una partícula cualquiera, como se denota a continuación:

E = mc2

Como la velocidad de la luz es muy grande, esta ecuación sugiere que cada partícula debe almacenar una cantidad enorme de energía, y en parte esta predicción fue la que hizo que la teoría de la relatividadtuviese tanta importancia para la física (¡y para todo el mundo!). Para que la teoría de la relatividadtambién sea autoconsistente tiene que ser holista, esto es, que todas las cosas y todo el mundo obedezcan a las leyes de la relatividad. No son sólo los relojes los que se atrasan a grandes velocidades, sino que todos los procesos animados se comportan de la forma tan inusual que describe esta teoría cuando nos acercamos a la velocidad de la luz. El corazón humano es simplemente un reloj biológico y latirá a una velocidad menor cuando viaje en un vehículo espacial a velocidades cercanas a la de la luz. Este extraño fenómeno conduce a lo que se conoce como la “paradoja de los gemelos”, sugerida por Einstein, en la que dos gemelos idénticos tienen diferente edad cuando se reencuentran después de que uno haya permanecido en la Tierra mientras que el otro ha viajado a velocidades relativistas.

Einstein comprendió rápidamente que las leyes de la gravedad también tendrían que ser modificadas para que cumplieran el principio relativista.

La formulación de newton es bien conocida, en la segunda imagen que se representan en este esquema dos partículas que se acercan entre sí siguiendo un movimiento acelerado. La interpretación newtoniana supone que el espacio-tiempo es llano y que lo que provoca la curvatura de las líneas de universo es la fuerza de interacción gravitatoria entre ambas partículas. Por el contrario, la interpretación einsteiniana supone que las líneas de universo de estas partículas son geodésicas (“rectas”), y que es la propia curvatura del espacio tiempo lo que provoca su aproximación progresiva.

Para poder aplicar el principio de la relatividad a la fuerza gravitatoria, el principio tuvo que ser extendido de la siguiente manera: no sólo debe ser imposible determinar la velocidad absoluta del laboratorio, sino que también es imposible distinguir los cambios de velocidad de los efectos de una fuerza gravitatoria.

Einstein comprendió que la consecuencia de esto era que la gravedad hace al espacio-tiempo lo que la humedad a una hoja de papel: deformar la superficie con desigualdades que no se pueden eliminar. Hoy en día se conocen muy bien las matemáticas de los espacios curvos, pero en el época de Einstein el uso de estas nociones matemáticas tan abstractas para formular leyes físicas era algo completamente nuevo, y le llevó varios años encontrar la herramienta matemática adecuada para formular su teoría general de la relatividad que describe cómo se curva el espacio en presencia de grandes masas como planetas y estrellas.

Einstein tenía la idea en su mente desde 1907 (la relatividad especial la formuló en 1905), y se pasó 8 años buscando las matemáticas adecuadas para su formulación.

Leyendo el material enviado por un amigo al que pidió ayuda, Einstein quedó paralizado. Ante él, en la primera página de una conferencia dada ante el Sindicato de Carpinteros, 60 años antes por un tal Riemann, tenía la solución a sus desvelos: el tensor métrico de Riemann, que le permitiría utilizar una geometría espacial de los espacios curvos que explicaba su relatividad general.

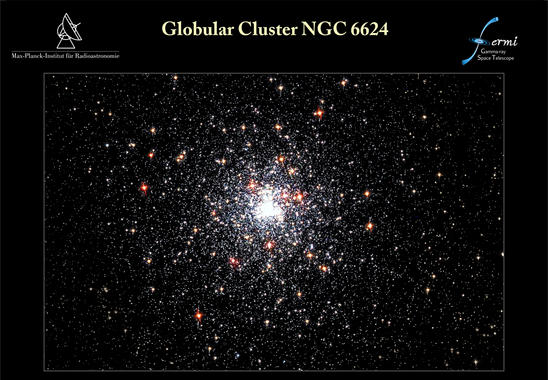

Desde que se puso en órbita el telescopio espacial de rayos gamma Fermi, el 11 de junio de 2008, ha detectado poblaciones enteras de objetos nunca antes vistos. El último hallazgo de Fermi afecta al púlsar J1823-3021A, avistado en 1994 con el radiotelescopio Lovell, en Inglaterra. Un equipo internacional de expertos se ha dado cuenta de que esta estrella pulsante emite rayos gamma y gracias a Fermi ha podido caracterizar sus inusuales propiedades. Los resultados de su investigación se publican en el último número de Science. Lo cierto es que han descubierto el púlsar de milisegundos más joven y con la fuerza magnética más potente

No está mal que en este punto recordemos la fuerza magnética y gravitatoria que nos puede ayudar a comprender mejor el comportamiento de las partículas subatómicas.

El electromagnetismo, decíamos al principio, es la fuerza con la cual dos partículas cargadas eléctricamente se repelen (si sus cargas son iguales) o se atraen (si tienen cargas de signo opuesto).

La interacción magnética es la fuerza que experimenta una partícula eléctricamente cargada que se mueve a través de un campo magnético. Las partículas cargadas en movimiento generan un campo magnético como, por ejemplo, los electrones que fluyen a través de las espiras de una bobina.

Las fuerzas magnéticas y eléctricas están entrelazadas. En 1873, James Clerk Maxwell consiguió formular las ecuaciones completas que rigen las fuerzas eléctricas y magnéticas, descubiertas experimentalmente por Michael Faraday. Se consiguió la teoría unificada del electromagnetismo que nos vino a decir que la electricidad y el magnetismo eran dos aspectos de una misma cosa.

La interacción es universal, de muy largo alcance (se extiende entre las estrellas), es bastante débil. Su intensidad depende del cociente entre el cuadrado de la carga del electrón y 2hc (dos veces la constante de Planck por la velocidad de la luz). Esta fracción es aproximadamente igual a 1/137’036…, o lo que llamamos α y se conoce como constante de estructura fina.

En general, el alcance de una interacción electromagnética es inversamente proporcional a la masa de la partícula mediadora, en este caso, el fotón, sin masa.

También antes hemos comentado sobre la interacción gravitatoria de la que Einstein descubrió su compleja estructura y la expuso al mundo en 1915 con el nombre de teoría general de la relatividad, y la relacionó con la curvatura del espacio y el tiempo. Sin embargo, aún no sabemos cómo se podrían reconciliar las leyes de la gravedad y las leyes de la mecánica cuántica (excepto cuando la acción gravitatoria es suficientemente débil).

La teoría de Einstein nos habla de los planetas y las estrellas del cosmos. La teoría de Planck, Heisemberg, Schrödinger, Dirac, Feynman y tantos otros, nos habla del comportamiento del átomo, del núcleo, de las partículas elementales en relación a estas interacciones fundamentales. La primera se ocupa de los cuerpos muy grandes y de los efectos que causan en el espacio y en el tiempo; la segunda de los cuerpos muy pequeños y de su importancia en el universo atómico. Cuando hemos tratado de unir ambos mundos se produce una gran explosión de rechazo. Ambas teorías son (al menos de momento) irreconciliables.

- La interacción gravitatoria actúa exclusivamente sobre la masa de una partícula.

- La gravedad es de largo alcance y llega a los más lejanos confines del universo conocido.

- Es tan débil que, probablemente, nunca podremos detectar esta fuerza de atracción gravitatoria entre dos partículas elementales. La única razón por la que podemos medirla es debido a que es colectiva: todas las partículas (de la Tierra) atraen a todas las partículas (de nuestro cuerpo) en la misma dirección.

La partícula mediadora es el hipotético gravitón. Aunque aún no se ha descubierto experimentalmente, sabemos lo que predice la mecánica cuántica: que tiene masa nula y espín 2.

La ley general para las interacciones es que, si la partícula mediadora tiene el espín par, la fuerza entre cargas iguales es atractiva y entre cargas opuestas repulsiva. Si el espín es impar (como en el electromagnetismo) se cumple a la inversa.

Pero antes de seguir profundizando en estas cuestiones hablemos de las propias partículas subatómicas, para lo cual la teoría de la relatividad especial, que es la teoría de la relatividad sin fuerza gravitatoria, es suficiente.

Si viajamos hacia lo muy pequeño tendremos que ir más allá de los átomos, que son objetos voluminosos y frágiles comparados con lo que nos ocupará a continuación: el núcleo atómico y lo que allí se encuentra. Los electrones, que ahora vemos “a gran distancia” dando vueltas alrededor del núcleo, son muy pequeños y extremadamente robustos. El núcleo está constituido por dos especies de bloques: protones y neutrones. El protón (del griego πρώτος, primero) debe su nombre al hecho de que el núcleo atómico más sencillo, que es el hidrógeno, está formado por un solo protón. Tiene una unidad de carga positiva. El neutrón recuerda al protón como si fuera su hermano gemelo: su masa es prácticamente la misma, su espín es el mismo, pero en el neutrón, como su propio nombre da a entender, no hay carga eléctrica; es neutro.

La masa de estas partículas se expresa en una unidad llamada mega-electrón-voltio o MeV, para abreviar. Un MeV, que equivale a 106 electrón-voltios, es la cantidad de energía de movimiento que adquiere una partícula con una unidad de carga (tal como un electrón o un protón) cuando atraviesa una diferencia de potencial de 106 (1.000.000) voltios. Como esta energía se transforma en masa, el MeV es una unidad útil de masa para las partículas elementales.

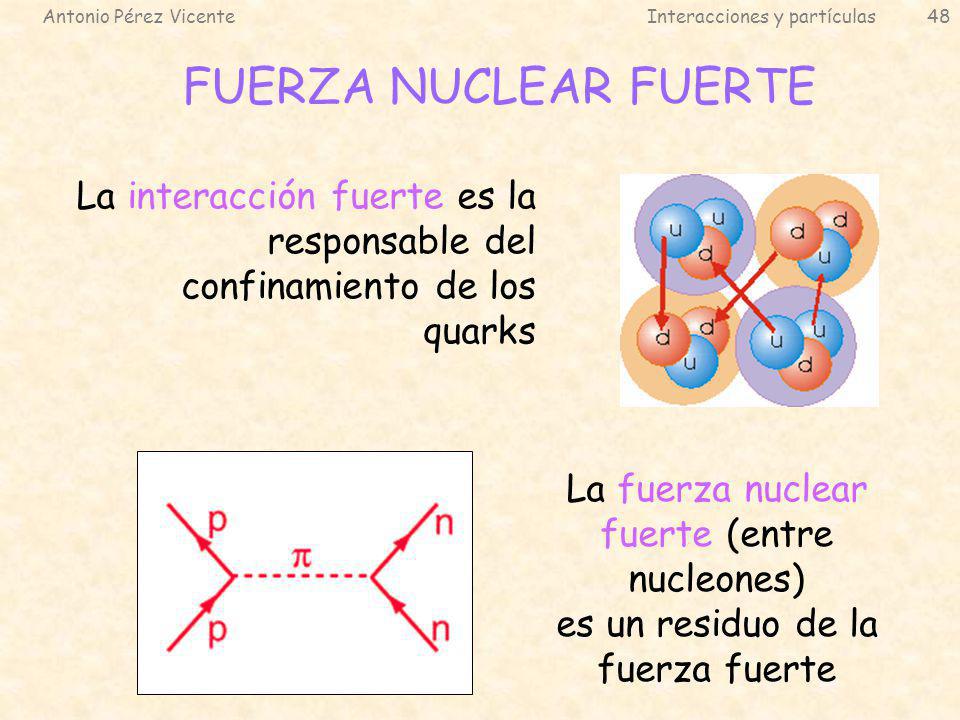

La mayoría de los núcleos atómicos contienen más neutrones que protones. Los protones se encuentran tan juntos en el interior de un núcleo tan pequeño que se deberían repeles entre sí fuertemente, debido a que tienen cargas eléctricas del mismo signo. Sin embargo, hay una fuerza que los mantiene unidos estrechamente y que es mucho más potente e intensa que la fuerza electromagnética: la fuerza o interacción nuclear fuerte, unas 102 veces mayor que la electromagnética, y aparece sólo entre hadronespara mantener a los nucleones confinados dentro del núcleo. Actúa a una distancia tan corta como 10-15 metros, o lo que es lo mismo, 0’000000000000001 metros.

La interacción fuerte está mediada por el intercambio de mesones virtuales, 8 gluones que, como su mismo nombre indica (glue en inglés es pegamento), mantiene a los protones y neutrones bien sujetos en el núcleo, y cuanto más se tratan de separar, más aumenta la fuerza que los retiene, que crece con la distancia, al contrario que ocurre con las otras fuerzas.

La luz es una manifestación del fenómeno electromagnético y está cuantizada en “fotones”, que se comportan generalmente como los mensajeros de todas las interacciones electromagnéticas. Así mismo, como hemos dejado reseñado en el párrafo anterior, la interacción fuerte también tiene sus cuantos (los gluones). El físico japonés Hideki Yukawa (1907 – 1981) predijo la propiedad de las partículas cuánticas asociadas a la interacción fuerte, que más tarde se llamarían piones. Hay una diferencia muy importante entre los piones y los fotones: un pión es un trozo de materia con una cierta cantidad de “masa”. Si esta partícula está en reposo, su masa es siempre la misma, aproximadamente 140 MeV, y si se mueve muy rápidamente, su masa parece aumentar en función E = mc2. Por el contrario, se dice que la masa del fotón en reposo es nula. Con esto no decimos que el fotón tenga masa nula, sino que el fotón no puede estar en reposo. Como todas las partículas de masa nula, el fotón se mueve exclusivamente con la velocidad de la luz, 299.792’458 Km/s, una velocidad que el pión nunca puede alcanzar porque requeriría una cantidad infinita de energía cinética. Para el fotón, toda su masa se debe a su energía cinética.

Los físicos experimentales buscaban partículas elementales en las trazas de los rayos cósmicos que pasaban por aparatos llamados cámaras de niebla. Así encontraron una partícula coincidente con la masa que debería tener la partícula de Yukawa, el pión, y la llamaron mesón (del griego medio), porque su masa estaba comprendida entre la del electrón y la del protón. Pero detectaron una discrepancia que consistía en que esta partícula no era afectada por la interacción fuerte, y por tanto, no podía ser un pión. Actualmente nos referimos a esta partícula con la abreviatura μ y el nombre de muón, ya que en realidad era un leptón, hermano gemelo del electrón, pero con 200 veces su masa.

Antes de seguir veamos las partículas elementales de vida superior a 10-20 segundos que eran conocidas en el año 1970.

| Nombre | Símbolo | Masa (MeV) | Carga | Espín | Vida media (s) |

| Fotón | γ | 0 | 0 | 1 | ∞ |

| Leptones (L = 1, B = 0) | |||||

| Electrón | e– | 0’5109990 | – | ½ | ∞ |

| Muón | μ– | 105’6584 | – | ½ | 2’1970 × 10-6 |

| Tau | τ | ||||

| Neutrino electrónico | νe | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino muónico | νμ | ~ 0 | 0 | ½ | ~ ∞ |

| Neutrino tauónico | ντ | ~ 0 | 0 | ½ | ~ ∞ |

| Mesones (L = 0, B = 0) | |||||

| Pión + | π+ | 139’570 | 2’603 × 10-8 | ||

| Pión – | π– | 139’570 | 2’603 × 10-8 | ||

| Pión 0 | π0 | 134’976 | 0’84 × 10-16 | ||

| Kaón + | k+ | 493’68 | 1’237 × 10-8 | ||

| Kaón – | k– | 493’68 | 1’237 × 10-8 | ||

| Kaón largo | kL | 497’7 | 5’17 × 10-8 | ||

| Kaón corto | kS | 497’7 | 0’893 × 10-10 | ||

| Eta | η | 547’5 | 0 | 0 | 5’5 × 10-19 |

| Bariones (L = 0, B = 1) | |||||

| Protón | p | 938’2723 | + | ½ | ∞ |

| Neutrón | n | 939’5656 | 0 | ½ | 887 |

| Lambda | Λ | 1.115’68 | 0 | ½ | 2’63 × 10-10 |

| Sigma + | Σ+ | 1.189’4 | + | ½ | 0’80 × 10-10 |

| Sigma – | Σ– | 1.1974 | – | ½ | 7’4× 10-20 |

| Sigma 0 | Σ0 | 0 | ½ | 1’48 × 10-10 | |

| Ksi 0 | Ξ0 | 1.314’9 | 0 | ½ | 2’9 × 10-10 |

| Ksi – | Ξ– | 1.321’3 | – | ½ | 1’64 × 10-10 |

| Omega – | Ω– | 1.672’4 | – | 1½ | 0’82 × 10-10 |

Para cada leptón y cada barión existe la correspondiente antipartícula, con exactamente las mismas propiedades a excepción de la carga que es la contraria. Por ejemplo, el antiprotón se simboliza con y el electrón con e+. Los mesones neutros son su propia antipartícula, y el π+ es la antipartícula del π–, al igual que ocurre con k+ y k–. El símbolo de la partícula es el mismo que el de su antipartícula con una barra encima. Las masas y las vidas medias aquí reflejadas pueden estar corregidas en este momento, pero de todas formas son muy aproximadas.

Los símbolos que se pueden ver algunas veces, como s (extrañeza) e i (isoespín) están referidos a datos cuánticos que afectan a las partículas elementales en sus comportamientos.

Debo admitir que todo esto tiene que sonar algo misterioso. Es difícil explicar estos temas por medio de la simple palabra escrita sin emplear la claridad que transmiten las matemáticas, lo que, por otra parte, es un mundo secreto para el común de los mortales, y ese lenguaje es sólo conocido por algunos privilegiados que, mediante un sistema de ecuaciones pueden ver y entender de forma clara, sencilla y limpia, todas estas complejas cuestiones.

Si hablamos del espín (o, con más precisión, el momento angular, que es aproximadamente la masa por el radio por la velocidad de rotación) se puede medir como un múltiplo de la constante de Planck, h, dividido por 2π. Medido en esta unidad y de acuerdo con la mecánica cuántica, el espín de cualquier objeto tiene que ser o un entero o un entero más un medio. El espín total de cada tipo de partícula – aunque no la dirección del mismo – es fijo.

El electrón, por ejemplo, tiene espín ½. Esto lo descubrieron dos estudiantes holandeses, Samuel Gondsmit (1902 – 1978) y George Uhlenbeck (1900 – 1988), que escribieron sus tesis conjuntamente sobre este problema en 1972. Fue una idea audaz que partículas tan pequeñas como los electronespudieran tener espín, y de hecho, bastante grande. Al principio, la idea fue recibida con escepticismo porque la “superficie del electrón” se tendría que mover con una velocidad 137 veces mayor que la de la luz, lo cual va en contra de la teoría de la relatividad general en la que está sentado que nada en el universo va más rápido que la luz, y por otra parte, contradice E=mc2, y el electrón pasada la velocidad de la luz tendría una masa infinita.

Hoy día, sencillamente, tal observación es ignorada, toda vez que el electrón carece de superficie.

En la segunda imagen podemos ver los signos del fotón, las W+, W– y Zº, así como el Gluon y por último, el reciente Bosón de Higgs. Cada una de estas partículas representan intermediación en las cuatro fuerzas fundamentales de la Naturaleza: El fotón las radiaciones electromagnéticas (la luz entre ellas), la W y Zº la fuerza nuclear electrodébil, los gluones la nuclear fuerte, el Bosón de Higgs que dicen proporciona la masa de las partíuclas, y, ausente está el gravitón, intermediario de la Gravedad que no ha podido ser hallado.

Las partículas con espín entero se llaman bosones, y las que tienen espín entero más un medio se llaman fermiones. Consultado los valores del espín en la tabla anterior podemos ver que los leptones y los bariones son fermiones, y que los mesones y los fotones son bosones. En muchos aspectos, los fermionesse comportan de manera diferente de los bosones. Los fermiones tienen la propiedad de que cada uno de ellos requiere su propio espacio: dos fermiones del mismo tipo no pueden ocupar o estar en el mismo punto, y su movimiento está regido por ecuaciones tales que se evitan unos a otros. Curiosamente, no se necesita ninguna fuerza para conseguir esto. De hecho, las fuerzas entre los fermiones pueden ser atractivas o repulsivas, según las cargas. El fenómeno por el cual cada fermión tiene que estar en un estado diferente se conoce como el principio de exclusión de Pauli. Cada átomo está rodeado de una nube de electrones, que son fermiones (espín ½). Si dos átomos se aproximan entre sí, los electrones se mueven de tal manera que las dos nubes se evitan una a otra, dando como resultado una fuerza repulsiva. Cuando aplaudimos, nuestras manos no se atraviesan pasando la uno a través de la otra. Esto es debido al principio de exclusión de Pauli para los electrones de nuestras manos que, de hecho, los de la izquierda rechazan a los de la derecha.

En contraste con el característico individualismo de los fermiones, los bosones se comportan colectivamente y les gusta colocarse todos en el mismo lugar. Un láser, por ejemplo, produce un haz de luz en el cual muchísimos fotones llevan la misma longitud de onda y dirección de movimiento. Esto es posible porque los fotones son bosones.

Cuando hemos hablado de las fuerzas fundamentales que, de una u otra forma, interaccionan con la materia, también hemos explicado que la interacción débil es la responsable de que muchas partículas y también muchos núcleos atómicos exóticos sean inestables. La interacción débil puede provocar que una partícula se transforme en otra relacionada, por emisión de un electrón y un neutrino. Enrico Fermi, en 1934, estableció una fórmula general de la interacción débil, que fue mejorada posteriormente por George Sudarshan, Robert Marschak, Murray Gell-Mann, Richard Feynman y otros. La fórmula mejorada funciona muy bien, pero se hizo evidente que no era adecuada en todas las circunstancias.

Uno de los protones se transmuta en un neutrón por medio de la interacción débil, transformando un quark “up”, en “down”. Este proceso consume energía (el neutrón tiene ligeramente más masa que..

En 1970, de las siguientes características de la interacción débil sólo se conocían las tres primeras:

- La interacción actúa de forma universal sobre muchos tipos diferentes de partículas y su intensidad es aproximadamente igual para todas (aunque sus efectos pueden ser muy diferentes en cada caso). A los neutrinos les afecta exclusivamente la interacción débil.

- Comparada con las demás interacciones, ésta tiene un alcance muy corto.

- La interacción es muy débil. Consecuentemente, los choques de partículas en los cuales hay neutrinos involucrados son tan poco frecuentes que se necesitan chorros muy intensos de neutrinos para poder estudiar tales sucesos.

- Los mediadores de la interacción débil, llamados W+, W– y Z0, no se detectaron hasta la década de 1980. al igual que el fotón, tienen espín 1, pero están eléctricamente cargados y son muy pesados (esta es la causa por la que el alcance de la interacción es tan corto). El tercer mediador, Z0, que es responsable de un tercer tipo de interacción débil que no tiene nada que ver con la desintegración de las partículas llamada “corriente neutra”, permite que los neutrinos puedan colisionar con otras partículas sin cambiar su identidad.

A partir de 1970, quedó clara la relación de la interacción débil y la electromagnética (electrodébil de Weinberg-Salam).

La interacción fuerte (como hemos dicho antes) sólo actúa entre las partículas que clasificamos en la familia llamada de los hadrones, a los que proporciona una estructura interna complicada. Hasta 1972 sólo se conocían las reglas de simetría de la interacción fuerte y no fuimos capaces de formular las leyes de la interacción con precisión.

Como apuntamos, el alcance de esta interacción no va más allá del radio de un núcleo atómico ligero (10-13 cm aproximadamente).

La interacción es fuerte. En realidad, la más fuerte de todas.

Lo dejaré aquí, en verdad, eso que el Modelo Estándar de la Física, es feo, complejo e incompleto y, aunque hasta el momento ha sido una buena herramienta con la que trabajar, la verdad es que, se necesita un nuevo modelo más avanzado y que incluya la Gravedad.

Existen esperanzas de que el LHC empleando energías más elevadas, nos pueda dar alguna sorpresa y encuentre objetos largamente perseguidos.

emilio silvera

May

12

La Denudación y otros fenómenos naturales

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Naturaleza...El Universo ~

Clasificado en La Naturaleza...El Universo ~

Comments (0)

Comments (0)

Bosques y Praderas

Otros mundos que podrían ser y que están en nuestros pensamientos, ninguno de los que podamos imaginar podrían ser negados, ya que, hasta el más extraño que podamos concebir estará en alguna parte, perdido en los confines de una galaxia lejana a millones de años luz, o, podría estar cerca de nuestra vecindad.

Hablemos de la Denudación y de otros fenómenos naturales:

Las poderosas fuerzas geomorfológicas pueden actuar suavemente. La acción de la gravedad puede mover, en cuestión de segundos, enormes volúmenes de tierra y piedras en devastadores deslizamientos y desprendimientos. Con lluvias intensas, la erosión en barrancos y cauces puede transformar los campos y las riberas, e inundar las llanuras durante horas o incluso días. Los vientos huracanados pueden, igualmente, modificar la fisonomía de las costas, y algunas superficies pueden ser remodeladas casi instantáneamente por erupciones volcánicas y terremotos. Pero la denudación de los continentes – el proceso debido a la acción de las inclemencias del tiempo, erosión meteórica y el posterior arrastre de los materiales erosionados – es un cambio gradual con tasas habitualmente bajas, que las alteraciones no se perciben durante el transcurso de una vida.

El Bubnoff (B) – la denudación de 1 mm en mil años (o 1 μm/año) – es una unidad conveniente para medir este cambio. Las precipitaciones, por disolución, reducen las duras rocas ígneas o metamórficas con una tasa comprendida entre 0’5 y 5 B, y las calizas hasta 100 B. La denudación en terrenos generalmente secos se produce a ritmos no mayores de 10 – 15 B, y en los trópicos húmedos llega a los 20 – 30 B. Los cambios en terrenos montañosos pueden ser mucho más importantes, llegando hasta 800 B en zonas de glaciares rápidos (sudeste de Alaska) y hasta los casi 10 KB en las zonas más recientes en continua elevación (la región de Nanga Parbat en el Himalaya). Pero incluso estas altas tasas de denudación son resultado de fuerzas modestas.

![]()

Un ejemplo de importancia medioambiental y económica ilustra este lento proceso geomorfológico de baja potencia. Si no hubiera erosión, la profundidad del suelo en los campos de cultivo sería mayor, pero su capa superior se empobrecería en nutrientes, ya que la erosión meteórica, si no es demasiado intensa, es la que repone los minerales en esta capa en la que crecen las raíces, ayudando a mantener la fertilidad del terreno.

La máxima pérdida de suelo compatible con el cultivo sostenido de cosechas es aproximadamente de 11 toneladas por hectárea en la mayor parte del terreno agrícola norteamericano. Cerca de dos quintas partes de los campos de ese país se están erosionando a tasas superiores, y la tasa media nacional de erosión, solamente por agua, es de casi diez toneladas por hectárea, equivalente a 550 B (suponiendo que la densidad del suelo es de 1’8 tn/m3).

El papel dominante de las lluvias en el proceso de la denudación se hace evidente cuando se compara la energía cinética de las gotas de lluvia con la energía de la escorrentía superficial. Las mayores gotas de lluvia, con diámetro comprendido entre 5 y 6 mm, alcanzan velocidades finales de 9 m/s, lo que implica que su energía cinética durante el impacto equivale aproximadamente a 40 veces su masa. Aunque la mitad de la precipitación corriera por la superficie a un velocidad media de un metro por segundo, la energía cinética sería una cuarta parte de la masa en movimiento. Consecuentemente, la erosión resultante de la caída de la lluvia sería dos órdenes de magnitud más potente que la corriente superficial.

La energía total de la denudación global del planeta se puede calcular suponiendo que afecta al menos a 50 B de material, con una densidad media de 2’5 g/cm3 (125 tn/m3) y que la altura media continental es de 850 m. Así, la energía de los campos de la Tierra se reduciría anualmente en 135 PJ. Este flujo, 4’3 GW, es muy pequeño comparado con otros flujos energéticos del planeta, representando el 0’05 por ciento de la energía potencial perdida por las corrientes superficiales de agua, el 0’01 por ciento del calor terrestre e igual a menos de 2×10-7 veces la radiación solar absorbida por las superficies continentales. Claramente, en la denudación de los continentes se invierte una parte insignificante de la radiación solar tanto directamente, a través de la luz solar, como indirectamente, con las corrientes de agua y el viento.

Además, hay fuerzas opuestas que anulan este lento cambio. Si no fuera por el continuo levantamiento tectónico, la cordillera alpina, con sus 4.000 metros de altura, sometida a una denudación de 1 – 5 B se nivelaría en menos de cinco millones de años, y sin embargo, la edad de la cordillera es actualmente un orden de magnitud superior.

Tasas de levantamiento comprendidas entre 5 – 10 B son bastantes frecuentes, y muchas regiones están elevándose con tasas superiores a 20 KB, es decir, una tasa hasta 10 veces superior a la tasa de denudación. No obstante, parece ser que en las zonas montañosas cuyas cumbres sobrepasan la cota de nieve, con grandes precipitaciones y gran actividad glacial, la altura está más limitada por una denudación rápida que por la elevación tectónica del terreno. El noroeste del Himalaya, incluyendo la zona del famoso Nanga Parbat, es un claro ejemplo, donde muchos de sus picos sobrepasan los 7.000 m y solamente el 1 por ciento del terreno los 6.000 m.

Encuentros espaciales

Siendo temibles localmente, son sucesos de relativa poca importancia globalmente habland0

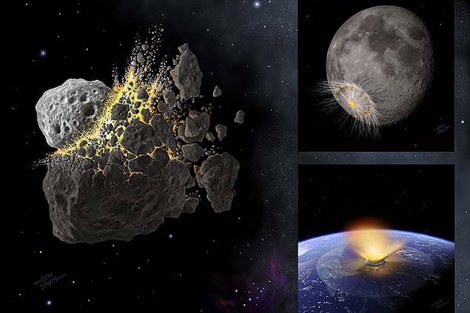

La más destructiva intensificación temporal de los normalmente suaves flujos de energía geotectónica – erupciones volcánicas o terremotos extraordinariamente potentes – o de energía atmosférica – vientos o lluvias anormalmente intensas -, parecen irrelevantes cuando se comparan con las repetidas colisiones del planeta con cuerpos extraterrestres relativamente grandes.

La caída sobre la Tierra de un Gran asteroide sí que es temible

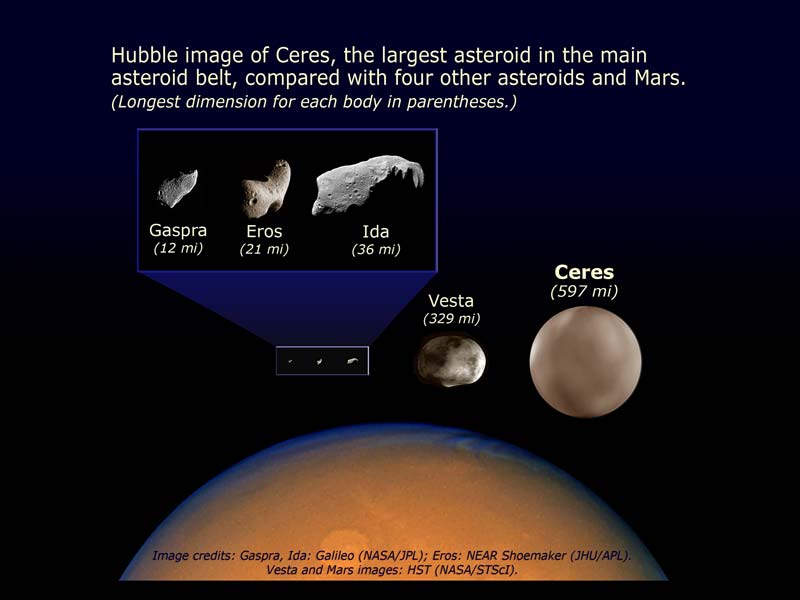

La Tierra está siendo bombardeada continuamente por invisibles partículas microscópicas de polvo muy abundantes en todo el Sistema Solar, y cada treinta segundos se produce un choque con partículas de 1 mm de diámetro, que dejan un rastro luminoso al autodestruirse en la atmósfera. También son relativamente frecuentes los choques con meteoritos de 1 metro de diámetro, que se producen con una frecuencia de, al menos, uno al año.

Pero los impactos, incluso con meteoritos mayores, producen solamente efectos locales. Esto es debido a que los meteoritos que deambulan por la región de asteroides localizada entre Marte y Júpiter están girando alrededor del Sol en el mismo sentido que la Tierra, de manera que la velocidad de impacto es inferior a 15 Km/s.

El cráter de Arizona, casi perfectamente simétrico, se formó hace 25.000 años por el impacto de un meteorito que iba a una velocidad de 11 Km/s, lo que representa una potencia cercana a 700 PW. Estas gigantescas liberaciones de energías palidecen cuando se comparan con un choque frontal con un cometa típico. Su masa (al menos de 500 millones de toneladas) y su velocidad relativa (hasta 70 Km/s) elevan su energía cinética hasta 1022 J. Aunque se perdiera un diez por ciento de esta energía en la atmósfera, el impacto sería equivalente a una explosión de unas 2.500 bombas de hidrógeno de 100 megatones. Está claro que un fenómeno de estas características produciría impresionantes alteraciones climatológicas. Sin embargo, no es seguro y sí discutible que un impacto parecido fuese la causa de la extinción masiva del cretácico, siendo lo más probable, si tenemos en cuenta el periodo relativamente largo en que se produjo, que se podría explicar por la intensa actividad volcánica de aquel tiempo.

La frecuencia de impactos sobre la Tierra disminuye exponencialmente con el tamaño del objeto.

Aproximadamente, cada cincuenta o sesenta millones de años se produce una colisión con un cometa, lo que significaría que la biosfera, que ha evolucionado durante cuatro mil millones de años, ha debido superar unos cuarenta impactos de este tipo. Está claro que ha salido airosa de estas colisiones, ya que aunque haya sido modificada, no ha sido aniquilada.

Igualmente, la evolución de la biosfera ha sobrevivido a las explosiones altamente energéticas de las supernovas más “cercanas”. Dado que en nuestra galaxia se produce por término medio la explosión de una supernova cada 50 años, el Sistema Solar se encuentra a una distancia de 100 parsecs de la explosión cada dos millones de años y a una distancia menor de 10 parsecs cada dos mil millones de años. En este último caso, la parte alta de la atmósfera se vería inundada por un flujo de rayos X y UV de muy corta longitud de onda, diez mil veces mayor que el flujo habitual de radiación solar, lo que implica que la Tierra recibiría, en unas pocas horas, una dosis de radiación ionizante igual a la que recibe anualmente. Exposiciones de 500 roentgens son setales para la mayoría de los vertebrados y, sin embargo, los diez episodios de esta magnitud que se han podido producir en los últimos 500 millones de años no han dejado ninguna consecuencia observable en la evolución de la biosfera.

La radiación cósmica o radiación espacial es el nombre que reciben todas aquellas partículas atómicas muy energéticas existentes en el Espacio. La radiación cósmica es incompatible con la vida, y, a los habitantes de la Tierra, los preserva el cinturón magnético que las rechaza para mantenernos a salvo

Si suponemos que una civilización avanzada podría preparar refugios para la población durante el año que transcurre ente la llegada de la luz y la llegada de la radiación cósmica, se encontraría con la inevitable dosis de 500 roentgens cada mil millones de años, tiempo suficiente para permitir el desarrollo de una sociedad cuyo conocimiento le sirviera para defenderse de un flujo tan extraordinario y de consecuencias letales. En realidad, somo frágiles dotados de una fortaleza descomunal.

Sí, la Naturaleza nos muestra constantemente su poder. Fenómenos que no podemos evitar y que nos hablan de unos mecanismos que no siempre comprendemos. Nuestro planeta por ejemplo, se comporta como si de un ser vivo se tratara, la llaman Gaia y realiza procesos de reciclaje y renovación por medio de terremotos y erupciones volcánicas, tsunamis y tornados debastadores que cambian el paisaje y nosotros, lo único podemos hacer es acatar el destino, ya que, ignoramos lo que está por venir.

El mundo nos parece un lugar complicado. Sin embargo, existen algunas verdades sencillas que nos parecen eternas, no varían con el paso del tiempo (los objetos caen hacia el suelo y no hacia el cielo, el Sol se levanta por el Este, nunca por el Oeste, nuestras vidas, a pesar de las modernas tecnologías, están todavía con demasiada frecuencia a merced de complicados procesos que producen cambios drásticos y repentinos. La predicción del tiempo atmosférico es más un arte que una ciencia, los terremotos y las erupciones volcánicas se producen de manera impredecible y aparentemente aleatoria, los cambios en las Sociedades fluctuan a merced de sucesos que sus componentes no pueden soportar y exigen el cambio.

La inmensa complejidad que está presente en el cerebro humano y de cómo se genera lo que llamamos “la mente”, a partir de una maraña de conexiones entre más de cien mil millones de neuronas, más que estrellas existen en nuestra Galaxia, la Vía Láctea. Es algo grande que, en realidad, no hemos alcanzado a comprender. Me hace gracia cuando alguna vez escucho decir a alguien: “Sólo utilizamos un diez por ciento de nuestro cerebro”. Lo cierto es que lo utilizamos al cien por ciento y, lo que en realidad quieren decir es que, se supone que el cerebro humano tiene un potencial tan grande que, de momento, sólo ha evolucionado hasta el diez por ciento de su capacidad futura. ¿Hasta dónde llegaremos?

emilio silvera

May

12

En el Centro Galáctico

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Artículo de Prensa ~

Clasificado en Artículo de Prensa ~

Comments (2)

Comments (2)

El centro galáctico – Chandra

El centro de nuestra galaxia, visto como nunca

Un vídeo en 360º realizado con datos de poderosos telescopios muestra la Vía Láctea desde el punto de vista de su agujero negro central

La Tierra se encuentra a unos 26.000 años luz del centro de nuestra galaxia, la Vía Láctea. Todavía resulta imposible viajar hasta allí, pero los científicos han podido estudiar esa región mediante el uso de poderosos telescopios que pueden detectar la luz en una varidad de formas. Ahora, un nuevo vídeo realizado con datos del Observatorio de Rayos X Chandra de la NASA y otros instrumentos permite a cualquier persona interesada echar un vistazo en 360º de ese fascinante entorno de máxima gravedad alrededor del agujero negro supermasivo conocido como Sagitario A*.

La visualización parte de los datos infrarrojos proporcionados por el Very Large Telescope del Observatorio Europeo Austral (ESO) de 30 enormes gigantes estelares llamados estrellas Wolf-Rayet, que orbitan a 1,5 años luz del centro de nuestra galaxia. Los poderosos vientos de gas que fluyen de la superficie de estas estrellas llevan algunas de sus capas externas al espacio interestelar.

Las estrellas lanzan al espacio ráfagas de energía que chocan con el material circundante

Cuando el gas que fluye entra en colisión con el gas expulsado previamente de otras estrellas, las colisiones producen ondas de choque que impregnan el área. Estas ondas de choque calientan el gas a millones de grados, lo que hace que brille en los rayos X. Amplias observaciones con Chandra de las regiones centrales de la Vía Láctea han proporcionado datos críticos sobre la temperatura y la distribución de este gas de varios millones de grados.

Los astrónomos están interesados en comprender mejor qué papel juegan estas estrellas Wolf-Rayet en el vecindario cósmico en el centro de la Vía Láctea (consulta aquí la investigación). En particular, les gustaría saber cómo interactúan con el vecino más dominante: Sagitario A *, que tiene una masa equivalente a unos cuatro millones de soles.

El centro galáctico es un lugar turbulento en el que no nos gustaría estar

La visualización del centro galáctico es una película de 360 grados que sumerge al espectador en una simulación del centro de nuestra galaxia. El espectador se encuentra en la ubicación de Sagitario A * y puede ver alrededor de 25 estrellas Wolf-Rayet (objetos blancos centelleantes) que giran en órbita a su alrededor a medida que expulsan continuamente vientos estelares (escala de color negro a rojo y amarillo). Estos vientos chocan entre sí, y luego parte de este material (manchas amarillas) gira en espiral hacia el agujero negro. La película muestra dos simulaciones, cada una de las cuales comienza alrededor de 350 años en el pasado y abarca 500 años. La primera simulación muestra a Sagitario A * en un estado tranquilo, mientras que en la segunda se lo ve más violento, expulsando su propio material, lo que desactiva la acumulación de material aglomerado (manchas amarillas) que es tan prominente en la primera parte.

Un estallido hasta hace cien años

… oscurece nuestra vista del centro galáctico. De este modo, se inició una carrera para ser el primero en detectar la fuente de rayos-X de Sagitario A*

Los científicos han utilizado la visualización para examinar los efectos que Sagitario A * tiene en sus vecinos estelares (el estudio, en Arxiv.org). A medida que la fuerte gravedad del agujero negro atrae grupos de material hacia el interior, las fuerzas de marea estiran los cúmulos. El pozo cósmico también impacta en su entorno a través de estallidos ocasionales que resultan en la expulsión de material lejos de sí mismo, como se muestra en la segunda parte del vídeo. Estos arrebatos pueden tener el efecto de eliminar parte del gas producido por los vientos de Wolf-Rayet.

A partir de estos datos, los investigadores, dirigidos por Christopher Russell, de la Pontificia Universidad Católica de Chile, han determinado que Sagitario A * pudo tener una relativamente poderosa explosión que se inició en los últimos siglos. Ese estallido todavía está afectando a la región a su alrededor, aunque terminó hace unos cien años.

El video en 360 grados del centro galáctico puede verse en teléfonos inteligentes utilizando la aplicación de YouTube. La mayoría de los navegadores de ordenador también permiten su visualización, pero para tener una óptica experiencia los científicos recomiendan utilizar gafas de realidad virtual (VR), como Samsung Gear VR o Google Cardboard.

May

11

No se puede viajar más rápido que la luz

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en realidad mañana ~

Clasificado en realidad mañana ~

Comments (7)

Comments (7)

Aunque planetas como Próxima b puedan ser habitables, ¿podremos viajar alguna vez hasta allí?

Fotograma de la La guerra de las galaxias (1977)

El gran parabrisas de la nave estelar deja ver el espacio profundo extendiéndose delante de los protagonistas. El piloto, normalmente con una sencilla palanca, acciona el mecanismo que pone en marcha los propulsores y la nave alcanza la velocidad de la luz en décimas de segundo. Mientras dejan atrás a sus perseguidores, la cabina se enciende y las estrellas más cercanas se convierten en trazas luminosas que se deslizan majestuosamente formando un túnel alrededor de los viajeros.

Pues bien… “Si esto [se refiere a la mítica escena arriba descrita de La Guerra de las Galaxias en la que Han Solo, Luke, la princesa Leia y Chebwacca escapan a bordo del Halcón milenario] ocurriese realmente, en menos de un segundo esa nave debería estallar, desintegrándose por completo y haciendo pedazos a todos sus ocupantes. Fin de la película”, reconoce entre risas Arturo Quirantes, profesor titular de Física en la Universidad de Granada.

En los últimos días, el anuncio oficial de la detección de Proxima b, un planeta potencialmente habitable en la estrella más cercana a la Tierra, ha hecho volar la imaginación de todos los apasionados a la ciencia y la exploración espacial. Durante décadas, el cine y la literatura de ciencia ficción nos han transportado de un mundo a otro mediante naves capaces de alcanzar la velocidad de la luz, y ahora que tenemos un planeta a la vuelta de la esquina muchos han empezado a hacer cálculos de cómo podrían llegar hasta allí.

La Voyager 1 que ya salió del Sistema solar y anda perdida por el Espacio Interestelar

La nave más rápida que jamás ha construido la humanidad se llama Voyager 1. Despegó hace casi 40 años y en estos momentos está alejándose del Sistema Solar a la increíble velocidad de 17 km/s, o lo que es lo mismo: algo más de 60.000 km/h.

El problema es que aunque pudiésemos subirnos ahora mismo en la Voyager tardaríamos más de 70.000 años en llegar a nuestro destino en Proxima b… Necesitamos viajar mucho más rápido, y es aquí donde llegan realmente los problemas.

La USS Enterprise de Star Treck se desplaza a velocidad WARP

La idea de viajar a velocidades cercanas a la luz no es sólo el sueño de un puñado de apasionados de la ciencia ficción, es un problema científico al que tarde o temprano tendremos que enfrentarnos si queremos explorar el espacio.

En abril de este mismo año un grupo de multimillonarios, como el ruso Yuri Milner o el creador de Facebook Mark Zuckerberg, con la asistencia científica de Stephen Hawking, presentaron Breakthrough Starshot, un proyecto de investigación que plantea la posibilidad de que pequeñas sondas alcancen un 20% de la velocidad de la luz, propulsadas por velas láser.

Totales: 75.650.119

Totales: 75.650.119 Conectados: 42

Conectados: 42