Oct

17

¿Quién nos observa? No podemos responder

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Vida en otros mundos ~

Clasificado en Vida en otros mundos ~

Comments (0)

Comments (0)

¡Nuestras Mentes! Esas desconocida

Si contáramos una sinapsis cada segundo, tardaríamos 32 millones de años en hacer el recuento. Si consideramos el número posible de circuitos neuronales, tenemos que habérnosla con cifras hiperastronómicas: 10 seguido de al menos un millón de ceros (En comparación con el número de partículas del universo conocido asciende a “tan sólo” 1079 es decir, es el número conocido como NEdd(Número de Eddintong) que es:

15.747.724.136.275.002.577.605.653.961.181.555.468.044.717914.527.116.709.366.231.425.o76185.631.031.296 protones y el mismo número de electrones, fue calculado por Arthur Eddintong allá por la década de 1920. Pues bien, esa descomunal cifra, se queda muy corta si la comparamos con las conexiones de nuestro cerebro. De ahí viene lo que decimos de que, “nuestros cerebros son las máquinas más complejas del Universo”. Y, desde luego, el comentario no está lejos de ser cierto.

¿La Vida? ¿Quién puede pararla?

Ahora sabemos que el universo tiene que tener miles de millones de años para que haya transcurrido el tiempo necesario par que las moléculas de la vida pudieran ser fabricadas en las estrellas y la gravitación nos dice que la edad del universo esta directamente ligada con otras propiedades como la densidad, temperatura, y el brillo del cielo.

:format(jpg)/f.elconfidencial.com%2Foriginal%2F048%2Fd92%2Fed4%2F048d92ed4c3bfa69ad53f67e3239b785.jpg)

Arriba, en el título del trabajo, os preguntaba: ¿Quién nos observa? Y, seguidamente os decía que ”No podríamos negar que esté sucediendo”. Lo cierto es que, si hacemos buena la lógica y las estadísticas aplicadas al Universo en el que existen cientos de miles de millones de estrellas como el Sol y, planetas como la Tierra un sin fin que, como el nuestro, estarán situados en la zona habitable— ¿Cómo negar la existencia de otras formas de vida, incluso, inteligentes, más adelantados que nosotros que nos estén observando?

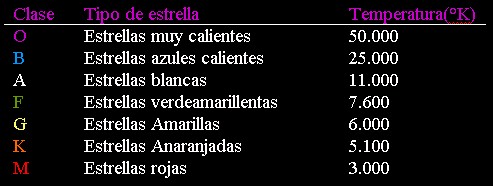

En galaxias lejanas de cientos de miles de millones de estrellas y en otras de menor volumen pero no por ello menos interesantes, existen extraños mundos que, aunque diferentes al nuestro, también viven y se nutren de la radiación y la luz estelar que les llega. Unos tienen soles azules y otros blancos, también los hay amarillos como el nuestro y muchos de ellos son rojos. Cada una de esas estrellas, configuran el color de sus respectivos mundos y los hace de color mortecino, de un azulado brillante o incluso, en ocasiones, de un color que influye en la atmósfera del planeta hasta hacerlo parecer de sangre. También los hay, como el nuestro, son luminosos y están alumbrados por estrellas blanco-azuladas que le dan un tono de exquisita presencia.

No todos los planetas que alberguen alguna clase de vida, ni en nuestra Galaxia ni en otras lejanas, tienen que ser como la Tierra. Existen planetas en los que se nos encogería el corazón por su aspectos terrorífico y de inabitable naturaleza, mientras que otros, nos parecerían una fantasía sacada de esos cuentos de hadas que de ñinos podíamos leer, tal es su belleza natural. En la Tierra tenemos muchas imágenes de lugares que hacen honor a ese pensamiento.

De la misma manera que existen estrellas de muchos tipos diferentes, así ocurre con los mundos que podemos encontrar repartidos por el universo orbitando estrellas que los configuran de mil diferentes maneras. Si nos fijamos en nuestro planeta que ha hecho posible nuestra presencia aquí, en el que junto a miles de otras especies hemos evolucionado, veremos que se han dado unas condiciones específicas para que todo eso sea posible.

Hemos podido llegar a un estado de evolución “aceptable” y alcanzado un nivel tecnológico que va más allá de lo que, hace sólo 200 años nos pudiéramos haber imaginado. Desde comienzo de la década de 1960, los programas de TV han emitido desde la Tierra hacia el espacio a un nivel de medio millón de watios. En la actualidad, la energía total emitida por las emisoras de televisión de todo el mundo es muy superior a los mil millones de watios. Durante los últimos quince años, esa cobertura expansiva de las emisoras de televisión, emitiendo desde la Tierra a la velocidad de la luz, ha podido llegar hasta centenares de estrellas y de mundos.

El observatorio de radio/radar de Arecibo en Puerto Rico. El disco hemisférico reflector está coronado por los brazos de alimentación sostenidos por tres grandes obeliscos, dos de los cuales aparecen deformados en la foto de la izquierda, tomada por Bill Ray con una lente de ojo de pez al nivel de los paneles que forman el disco. (Cedidas por el Centro Nacional de Astronomía y de la Ionosfera, Universidad de Cornell.)

Enormes radares situados por todo el mundo lanzando ondas han podido ser la evidencia inequívoca de que aquí, en la Tierra, existen seres inteligentes que tratan de captar señales venidas del espacio exterior, de vigilar los posibles peligros que nos puedan llegar de mñás allá de los confines del Sistema solar, o, de captar esas señales que denoten la presencia de otros seres inteligentes que, situados en otros mundos lejanos, nos quieren decir alguna cosa o transmitir algún mensaje. Nosotros ya lo hemos intentado y continuamos haciendolo.

¿Cómo serán ellos? Lo cierto es que cualquier cosa que podamos imaginar podría ser cierta

Cualquier mundo que podamos imaginar… también podría existir lejos del nuestro. Es cierto que, hasta el momento, no tenemos pruebas de la existencia de vida extraterrestre. Sin embargo, como decía un gran cosmólogo: “La ausencia de pruebas no es prueba de ausencia”.

Lo cierto es que hemos llegado a comprender que la vida en la Tierra, toda sin excepción está basada en el Carbono y, como también sabemos que las leyes del Universo son las mismas en todas partes, es lógico pensar que lo que pasó aquí habrá podido pasar allí, en cualquier planeta lejano situado en nuestra Galaxia o en cualquiera de la multitud de galaxias que conforman nuestro universo en el que cientos de miles de millones de mundos, no pueden estar vacíos y carentes de vida.

Todas esas señales y las que emitimos con nuestro quehacer diario, hacen que nuestro planeta brille hasta parecer un ascua encendida en la oscuridad . Las frecuencias de televisión y las bandas de FM de las emisoras de radio nos delatan ante posibles inteligencias en otros mundos. Radioastrónomos situados en otros sistemas solares notarán, al enfocar sus antenas en nuestra dirección, una emisión de energía y advertirán que, en esta estrella amarrilla, existe una sociedad científicamente avanzada.

Ucrania no sería un buen sitio para presentarnos

Las segunda imagen nos muestra lo que las civilizaciones extraterrestres estarían viendo en este momento si pudieran monitorear trasmisiones de televisión de la Tierra, de esas trasmisiones del pasado que ingresaron al espacio y se propagan a la velocidad constante de c (la velocidad de la luz en el vacío).

Claro que nuestras señales televisivas le dicen a los extraterrestres mucho más que todo eso. A partir de sutiles cambios en las frecuencia de las señales provocados por la rotación de la Tierra, podrían deducir la distancia que hay entre la Tierra y el Sol, la probable temperaturta de la superficie de nuestro planeta y, a partir de aquí, que clase de vida puede haber en la Tierra. ¡Sabrían de nosotros mucho más que nosotros sabemos de ellos! Bueno, en realidad, de ellos no sabemos nada.

Si los astrónomos extraterrestres de otros sistemas solares han estado haciendo un seguimiento de nuestros progresos, tienen ya prueba de que esta vida ha atravesado ya un importante umbral tecnológico, el umbral de las comunicaciones de radio. Los científicos extraterrestres pueden deducir a partir de su propia experiencia que esa conquista puede verse pronto continuada por un dominio de los viajes por el espacio que es la siguiente escala perseguida. Primero de un planeta a otro cercano. En nuestro caso, digamos a Marte, y, a continuación, y no mucho después. Comenzarán los viajes que nos llevarán a los confines del Sistema Solar en busca de otras fronteras. Sin que nos demos cuenta, ya hemos enviado el mensaje de nuestra presencia que es el precursor de nuestra entrada en la Comunidad Galáctica.

Si realmente existen esos seres que imaginamos en otros mundos y, si como es lógico pensar, al igual que nosotros han podido evolucionar hasta alcanzar aceptables niveles del saber sobre la Naturaleza y los secretos del Universo, también habrán podido alcanzar una avanzada tecnología que, más o menos como la nuestra, les posibilite para enviar señales y hacer viajes espaciales que (no me extrañaría nada) estuvieran ya camino hacia nosotros.

Millones de mundos que, como el nuestro, brillaran en la noche delatando la presencia de Sociedades avanzadas que, situadas en grandes ciudades dejan transcurrir sus vidas mientras, también como nosotros, no dejan de investigar y de hacerse preguntas que, tampoco ellos, saben contestar. El saber del mundo, de los mundos, está repartido por todo el Universo que es, en definitiva, el que tiene todas esas respuestas que buscamos. Para nosotros, son las distancias las que imponen su ley y nos impiden llegar a ellos. Sin embargo, las tecnologías que vienen de camino… ¡Nos abrirán esas puertas cerradasd!

Muchas veces me hago esta pregunta: ¿De qué estrella vendrá esa primera señal de inteligencia que esperamos? Las civilizaciones que la envíe ¿a qué distancia estará, cómo será su mundo, cuánto tiempo ha tardado en llegar a nosotros, y, cuando la podamos descifrar, y contestemos, cuánto tardarán en tener la respuesta? Incluso es posible -seguramente lo normal-, que esas señales hayan sido enviadas ya por ambas partes y que, ni ellos ni nosotros, debido a las distancias que nos separan, la hemos podido recibir. ¡Qué frustración, pensar que eso es así y no poder hacer nada por remediarlo!

Ya hablamos el otro día de las estrellas cercanas, las que estaban situadas dentro de un radio de unos doce años-luz y de las posibilidades que podían existir de que, en alguna de ellas (de sus planetas), pudiera existir alguna clase de vida. La presencia de vida inteligente en el inmenso universo, debe ser una cosa cotidiana, nada excepcional. Sin embargo, tal como están dispuestas las cosas, lo que no parece tan cotidiano es, el hecho de que, entre civilizaciones inteligentes nos podamos encontrar, las inconmensurables distancias que nos pueden separar son… ¡casi inaccesibles! y, el tiempo necesario para recorrerlas, vería pasar ante él a muchas generaciones de individuos antes de que, entre ellos, pudiera darse ese contacto tantas veces imaginado.

Es poco probable que los que, ilusionados, lanzaron la señal hacia otros mundos. El mensaje que les hermanaría gracias a la inteligencia, pudiera ver realizados sus sueños de recibir una respuesta. El Proyecto OZMA y SETI son un buen ejemplo de ello. Y, por otra parte, no todas las estrellas están en disposición de poder dar a sus planetas lo que estos necesitan para albergar la vida. Pensemos que una estrella si es muy joven, digamos de unos cientos de millones de años, radiará en el ultravioleta con tal virulencia que, encontrar vida en sus inmediaciones sería imposible. Si por el contraria es una estrella vieja que, al final de su vida está a punto de explotar como supernova… tampoco parece que su entorno sea el adecuado.

Las estrellas y los mundos que puedan ser idóneas para que la vida esté presente, tendrán que tener esas condiciones mínimos exigidas para que, el agua esté presente, para que una atmósfera aceptablemente importante configure el planeta, que éste tenga una serie de parámetros de magnetismo, tectónica, océanos y otros que lo haga un planeta vivo, que la luz de la estrella lo caliente sin achicharrarlo… Si todo eso y algunas cosas más están presentes… La vida también lo estará.

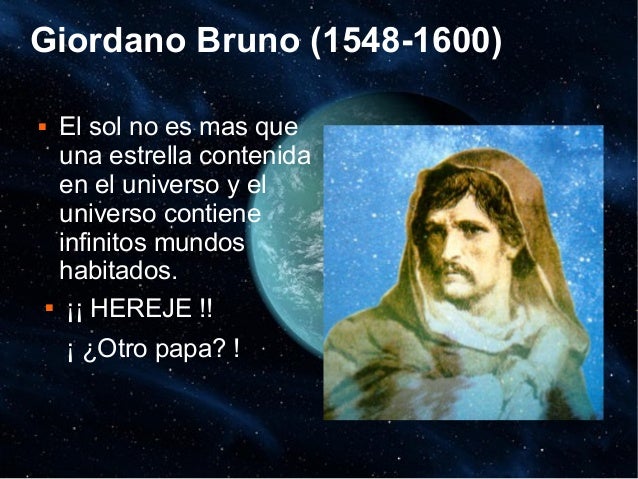

El pobre Giordano murió en la hoguera, sus ideas en aquel tiempo no eran para expresarlas en alto

Pero lo cierto es que, aunque la lógica nos dice que están ahí… ¡Seguimos sin recibir señales de que la vida está ahí fuera! El principal problema de que así sea, está en las distancias que nos separan y, simplemente tenemos que pensar que cualquier estrella orbitada por planetas está a muchos años-luz de nosotros y, las que puedan tener alguna posible forma de vida inteligente, no sabemos cuán lejos podrán estar situadas y, para llegar a nosotros, esas señales, necesitan recorrer el espacio que nos separa a la máxima velocidad que el universo permite, es decir, la velocidad de la luz de 299.792,458 km/s. Un viaje algo lento para que llegue a nosotros en un tiempo prudencial. Y si llegan, quién las sabrá traducir, y, si al fin las traducimos y enviamos la respuesta… ¿Quién la recibirá?

Seguramente, para cuando ese contacto se pueda producir, las civilizaciones que se encuentren, tendrán otros medios más avanzados que el de los viajes clásicos de las naves viajeras tal como las conocemos y, serán otras naves y otros caminos los que serán recorridos para viajar entre las estrellas. El Hiperespacio y los agujeros de gusano son dos buenas opciones pero… ¡habrá tantas!

Y, como decía aquel gran pensador: “Que no está muerto lo que duerme eternamente, y, con el paso de los Eones, hasta la misma muerte tendrá que morir.”

Emilio Silvera Vázquez

Oct

17

Nuestra situación en la Galaxia, nuestro universo y más allá

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en ¿Dónde estamos dentro de la Galaxia? ~

Clasificado en ¿Dónde estamos dentro de la Galaxia? ~

Comments (5)

Comments (5)

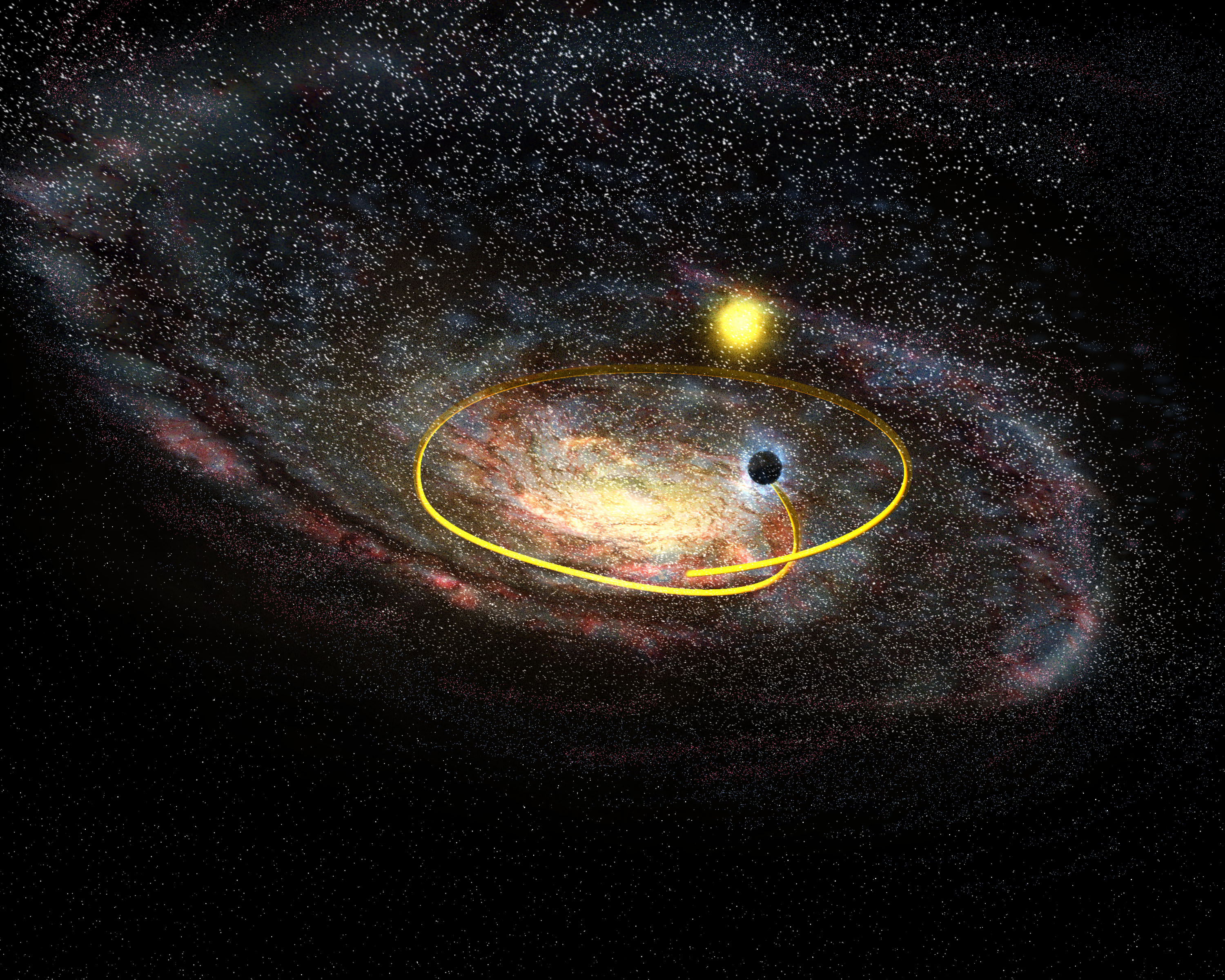

El Sistema Solar está situado en uno de los tres brazos en espiral de esta galaxia llamado Orión, a unos 27.000/30.000 años luz del núcleo, alrededor del cual gira a la velocidad de 250 km por segundo, empleando 225 millones de años en dar una vuelta completa, lo que se denomina año cósmico. El Sistema Solar que es un sistema planetario compuesto por ocho planetas que giran en torno al Sol, la única estrella de este sistema.

El límite imaginario entre El Sistema Solar y el espacio interestelar se estima que está a 100 U.A., aproximadamente unos 15.000 millones de kilómetros de nuestro Sol. Este límite o frontera recibe el nombre de heliopausa y, como decimos, es imaginario debido a que en el Universo hay más vacío que materia.

En este vacío (espacio interplanetario) hay material proveniente de diferentes elementos de la Galaxia, tanto de cometas y asteroides como de la actividad de los planetas que expulsan partículas que, al no ser retenidas por atmósfera alguna, escapan al espacio. Por tanto, podría decirse que el polvo del espacio interplanetario es una variedad del polvo interestelar.

La galaxia de la Vía Láctea, o simplemente la Vía Láctea, es una galaxia espiral donde se encuentra el Sistema solar y a su vez se encuentra la Tierra el planeta que acoge a nuestra especie y muchas más. Según las observaciones, posee una masa de 1012 masas solares y es una espiral barrada. Su diámetro medio se estima en unos 100 000 años luz, equivalentes a casi un trillón y medio (1,42×1018) de kilómetros o 9480 millones de unidades astronómicas. Se calcula que contiene entre 200 000 y 400 000 millones de estrellas. La distancia desde el Sol hasta el centro de la galaxia (según las últimas medidas más refinadas) es de alrededor de 25 766 años luz (7900 pc.). es decir, el 52 % del radio total galáctico. La Vía Láctea forma parte de un conjunto de unas cuarenta o cincuenta galaxias llamado Grupo Local, y es la segunda más grande y brillante tras la galaxia Andrómeda (aunque puede ser la más masiva, como lo muestra un estudio reciente).

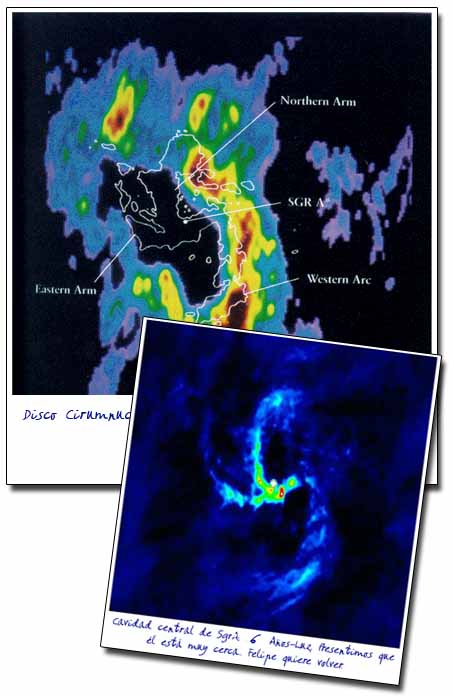

Desde la Tierra el núcleo de la Galaxia se ve de la manera que arriba podemos observar.

Así las cosas, sabemos que estamos situados en el Brazo de Orión a 25 766 años luz del centro galáctico, y, sabiendo que el diámetro galáctico es de unos 100.000 años luz, nosotros, estamos situados a 24.234 años luz del borde de la galaxia del núcleo hacia abajo, y, sin embargo, existe una extraña curiosidad.

Veamos:

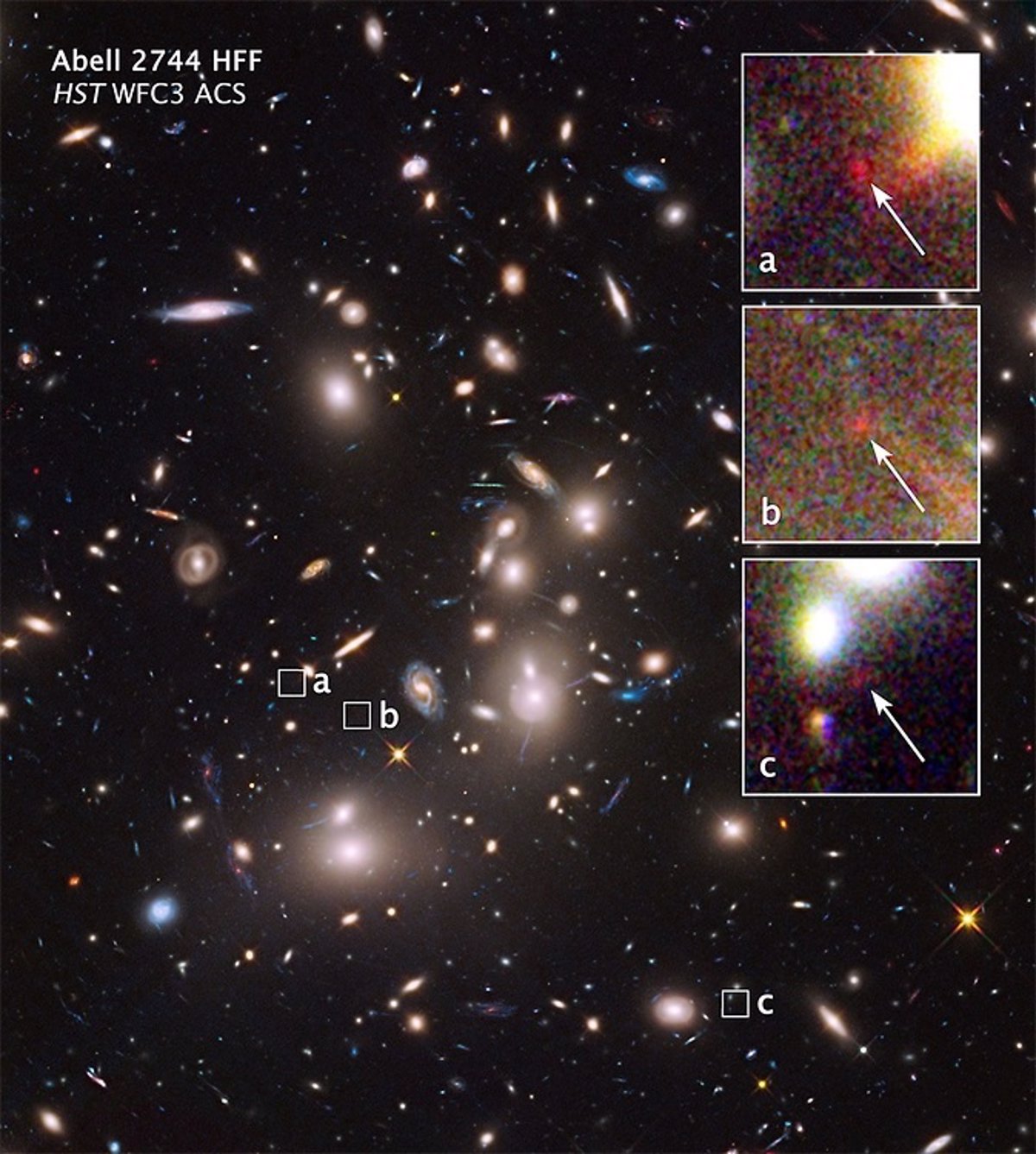

Hubble capta una pequeña galaxia a 13.000 millones de años luz

El Telescopio Espacial Hubble ha captado galaxias situadas a 13.000 millones de años luz de nuestro Sistema solar, y, sin embargo, nunca parece haberse dirigido hacia ese lugar del borde de la Galaxia situado a sólo 24.234 años luz que nos separa de él para saber que es lo que allí pueda haber.

Resulta extraño que podamos conocer lugares tan lejanos de nosotros y, sin embargo, otros más cerca de nosotros, nos son desconocidos. De todas las maneras, en esto del Espacio, las cosas son poco usuales y se salen de nuestras experiencias cotidianas, las enormes distancias lo hacen todo diferente. Acordáos de aquella misión llamada Voyager 1 y 2

La Sonda Voyager 1.

La razón de que se lanzasen estas naves cuando se lanzaron (en agosto y septiembre de 1977) era que Júpiter, Saturno, Urano y Neptuno estaban alineados de una forma que sólo se da una vez cada 175 años. Esto permitía a las dos naves utilizar una técnica de«aprovechamiento de la gravedad» por la que eran lanzadas sucesivamente de un gigante gaseoso al siguiente en una especie de versión cósmica de chasquido de látigo. Aun así, tardaron nueve años en llegar a Urano y doce en cruzar la órbita de Plutón. A estas alturas han salido del Sistema Solar y andan por el Espacio Interestelar hacia las profundidades del Cosmos.

El Sol visto desde los planetas del Sistema Solar y Plutón.

En un vacío tan solitario se puede empezar a entender por qué han escapado a nuestra atención incluso los objetos más significativos (las lunas de Plutón, por ejemplo). Y Plutón no ha sido ni mucho menos un caso único a ese respecto. Hasta las expediciones del Voyager, se creía que Neptuno tenía dos lunas. El Voyager descubrió otras seis. Hace algunos años, se creía que había 30 lunas en el sistema solar. Hoy el total es de 9o, como mínimo, y aproximadamente un tercio de ellas se han descubierto en los últimos años. Lo que hay que tener en cuenta, claro, cuando se considera el universo en su conjunto, es que ni siquiera sabemos en realidad lo que hay en nuestro sistema solar.

/cdn.vox-cdn.com/uploads/chorus_image/image/50082107/RR245orbit_labeled.0.0.png)

El Cinturón de Kuiper.

Después de Plutón hemos de pasar por El Cinturón de Kuiper. Es una región en forma de disco que se encuentra más allá de la órbita de Neptuno, aproximadamente entre 30 y 100 UA (Unidades Astronómicas) del Sol, que contiene muchos pequeños cuerpos helados. Actualmente se le considera la fuente de los cometas de periodo corto. Aunque los valores de las estimaciones son bastante variables, se calcula que existen al menos 70.000 “transneptunianos” entre las 30 y 50 unidades astronómicas, con diámetros superiores a los 100 km. Más allá de las 50 UA es posible que existan más cuerpos de este tipo, pero en todo caso están fuera del alcance de las actuales técnicas de detección. Las observaciones muestran también que se hallan confinados dentro de unos pocos grados por encima o por debajo del plano de la eclíptica. Estos objetos se les conoce como KBO’s (Kuiper Belt Objects).

Universo visible, desde 13.700 hasta 180.000 millones de años luz. Aunque la edad del universo sea de 13.700 millones de años, la expansión producida debido al Big Bang hace que el universo más lejano observable se haya alejado mucho más que esa distancia, a pesar de haber recorrido menos de 13.700 millones de años luz (1,37×10^10).

La verdadera distancia comóvil al extremo del universo visible es sobre 46.500 millones de años luz en todas las direcciones desde la Tierra, así el Universo visible se puede considerar como una esfera perfecta con la Tierra en el centro y un diámetro de unos 93.000 millones de años luz/880.000 trillones de km (5.865 billones de UA). Hay que notar que muchas fuentes han publicado una amplia variedad de cifras incorrectas para el tamaño del Universo visible, desde 13.700 hasta 180.000 millones de años luz. Aunque la edad del universo sea de 13.700 millones de años, la expansión producida debido al Big Bang hace que el universo más lejano observable se haya alejado mucho más que esa distancia, a pesar de haber recorrido menos de 13.700 millones de años luz (1,37×10^10).

Imagen que explica la diferencia sobre el dato de la edad del universo (1.37×1010 años luz) en comparación a la estimación sobre el radio real del universo observable (4.65×1010 años luz).4 La explicación de tal sería que al mirar la radiación de fondo y las galaxias más lejanas se observa el pasado con una mayor densidad de materia por centímetro cúbico del universo.

Siendo el Big Bang la Teoría más aceptada y la que mejor concuerda con la observación, lo cierto es que, nunca hemos podido conocer el principio, es decir, no hemos sido capaces de traspasar esa línea invisible del Tiempo de Planck. ¿Qué pasó más allá de ella en ese infinitesimal espacio de tiempo… ¡No lo sabemos!

Por otra parte, es curioso no conociendo el principio, tampoco conozcamos el final, es decir, ¿Qué habrá el borde del Universo? Si el Universo tiene un principio debe tener un final y, ese final, supongamos que es un borde formado por las últimas galaxias del Universo… ¿Qué habrá más allá?¿Acaso espacios vacíos que al recorrerlos nos llevaría hasta otros Universo?

Si miramos nuestro universo veremos que todo se repite una y otra vez: Las galaxias y las estrellas, los mundos, los púlsares y estrellas de neutrones, las Nebulosas… Los Agujeros negros y los Cuásares… Siempre las mismas cosas y, de entre ellas, los mundos que, en ocasiones, pueden tener seres vivos. Y, si eso es así (que los es), ¿por qué no otros universos?

Una posibilidad real

Por todas estas razones, se debe considerar seriamente la posibilidad de que vivamos en un multiverso. Esto podría ayudar a comprender los problemas de la complejidad y de la sencillez. El hecho de que las leyes y consensos de la física parezcan tan afinados como para permitir la existencia de la vida en ingentes cantidades procedentes de valores extremadamente “improbables”, resulta obvio a partir de la suposición de que nuestro universo es sólo una pequeña parte de un vasto multiverso, en el que las diferentes regiones presentan leyes distintas. Desde esta perspectiva, vivimos en una de las áreas “antrópicamente favorables”. (En cosmología el Principio Antrópico establece que cualquier teoría válida sobre el universo tiene que ser consistente con la existencia del ser humano.)

Esta selección antrópica posee dimensión estrictamente teleológica y no teológica, sin ninguna relación con cualquier tipo de “Diseño Inteligente”. No sería otra cosa que la generalización evidente del efecto de selección que ya debe ser considerado dentro de nuestro propio universo. Cuando se maneja cualquier muestra, resulta imposible no preguntarse si es representativa del conjunto entero, y esta cuestión por supuesto debe extenderse cuando se considera nuestro universo dentro del multiverso.

El Hublle ha captado la galaxia más lejana hasta el momento

A pesar de que la luz que emite es extremadamente tenue, los autores del hallazgo consideran que la galaxia, denominada GN-z11, es sorprendentemente brillante, teniendo en cuenta la descomunal distancia que le separa de la Tierra: 13.400 millones de años luz. La medición de este objeto aporta una prueba contundente de que otras galaxias brillantes detectadas en anteriores imágenes del Hubble se encuentran sin lugar a dudas a distancias extraordinarias, lo cual demuestra que los astrónomos están logrando explorar las galaxias más primitivas que se formaron en el Universo.

este hallazgo ubica a GN-z11 a una distancia que hasta ahora se pensaba que sólo podría captar el futuro Telescopio James Webb, cuyo lanzamiento está previsto en 2018. Esperémos que, cuando el nuevo Telescopio esté en funcionamiento, nos pueda llevar mucho más lejos y decirnos, que hay más allá del “borde del Universo”.

Emilio Silvera Vázquez

Oct

17

¿La Realidad? ¿Dónde estará?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La realidad humana ¿es realidad? ~

Clasificado en La realidad humana ¿es realidad? ~

Comments (1)

Comments (1)

No una sino mil veces podemos haber podido hablar del “milagro griego”. La hipótesis es la siguiente: La Ciencia nació en la antigua Grecia alrededor del año 600 a. C. y floreció durante unos pocos cientos de años, aproximadamente hasta 146 a. C., cuando los griegos cedieron su primacía a los romanos y la ciencia se frenó en seco, permaneció en letargo hasta que resucitó en Europa durante el Renacimiento alrededor de 1500. Y, no pocos creen a pie juntillas que eso fue así y que, las personas que habitaron la India, Egipto, Mesopotamia, el África Subsahariana, China, el Continente americano y algún otro lugar con anterioridad al año 600 a. C. no dirigieron el desarrollo de la Ciencia. Cuando descubrieron el fuego, se quedaron esperando tranquilamente a que Tales de Mileto, Pitágoras, Demócrito y Aristóteles inventaran la Ciencia en el Egeo.

146 a. C., cuando los griegos cedieron su primacía a los romanos y la ciencia se frenó en seco, permaneció en letargo hasta que resucitó en Europa durante el Renacimiento alrededor de 1500. Y, no pocos creen a pie juntillas que eso fue así y que, las personas que habitaron la India, Egipto, Mesopotamia, el África Subsahariana, China, el Continente americano y algún otro lugar con anterioridad al año 600 a. C. no dirigieron el desarrollo de la Ciencia. Cuando descubrieron el fuego, se quedaron esperando tranquilamente a que Tales de Mileto, Pitágoras, Demócrito y Aristóteles inventaran la Ciencia en el Egeo.

Claro que, tal pensamiento es una auténtica barbaridad, pensar eso es un sin sentido. ¿Cómo durante más de mil quinientos años, desde el final del período griego hasta la época de Copérnico, no se produjo avance alguna en la Ciencia? Esto quiere decir que ninguna persona, en ninguna parte, demostró la capacidad o el interés necesario para proseguir insistiendo en las obras de Arquímedes, Euclides o Apolonio.

el final del período griego hasta la época de Copérnico, no se produjo avance alguna en la Ciencia? Esto quiere decir que ninguna persona, en ninguna parte, demostró la capacidad o el interés necesario para proseguir insistiendo en las obras de Arquímedes, Euclides o Apolonio.

Lo cierto es que da mucha pena comprobar como el paso del tiempo hace desaparecer aquellas culturas

Las primeras observaciones sobre fenómenos eléctricos se realizaron ya en la antigua Grecia, cuando el filósofo Tales de Mileto (640-546 a.C.) comprobó que, al frotar barras de ambar contra pieles curtidas, se producía en ellas características de atracción que antes no poseían. Es el mismo experimento que ahora se puede hacer frotando una barra de plástico con un paño; acercándola luego a pequeños pedazos de papel, los atrae hacia sí, como es característico en los cuerpos electrizados.

se puede hacer frotando una barra de plástico con un paño; acercándola luego a pequeños pedazos de papel, los atrae hacia sí, como es característico en los cuerpos electrizados.

Sin embargo, fue el filósofo griego Theophrastus (374-287 a.C.) el primero, que en un tratado escrito tres siglos después, estableció que otras sustancias tienen este mismo poder, dejando así constancia del primer estudio científico sobre la electricidad. Comprobando que no todos los materiales pueden adquirir tal propiedad o adquirirla en igual medida. Se atraen, por ejemplo, una barra de vidrio y otra de ebonita. Se repelen, sin embargo, dos barras de vidrio o dos de ebonita.

mismo poder, dejando así constancia del primer estudio científico sobre la electricidad. Comprobando que no todos los materiales pueden adquirir tal propiedad o adquirirla en igual medida. Se atraen, por ejemplo, una barra de vidrio y otra de ebonita. Se repelen, sin embargo, dos barras de vidrio o dos de ebonita.

Gradas y restos del edificio de la escena del teatro de Mileto. Mileto (en cario: Anactoria; en hitita: Milawata o Millawanda; en griego antiguo Μίλητος Mílêtos; en turco: Milet) fue una antigua ciudad griega de la costa occidental de Anatolia (en la actual provincia de Aydın de Turquía), cerca de la desembocadura del río Meandro en la antigua Caria. El emplazamiento estuvo habitado desde la Edad del Bronce.

Aquellos ”científicos” se reunieron en Mileto. Tales, Anaximandro y Anaxímenes hicieron observaciones astronómicas con el gnomon, diseñaron cartas naúticas, plantearon hipótesis más o menos relacionadas con los hechos observados referidas a la estructura de la Tierra, la naturaleza de los planetas y las estrellas, las leyes seguidas por los astros en sus movimientos. En Mileto, la ciencia, entendida como interpretación racional de las observaciones, aparece que dio los primeros pasos

interpretación racional de las observaciones, aparece que dio los primeros pasos

Claro que, las cosas nunca suelen ser tan sencillas. La hipótesis según la cual la ciencia surgió por generación espontánea en suelo griego y desaparecido después hasta el Renacimiento parece ridícula cuando se expresa de forma sucinta, sin más explicaciones. Es una idea que se formuló por primera vez en Alemania hace unos 150 años y que, poco a poco, ha ido calando, sutilmente en nuestras consciencias a través de la educación que, la única concesión que se hace a las culturas no europeas es la que se refiere al Islam. Esta teoría dice que los árabes conservaron viva la cultura griega, incluida la ciencia, durante toda la Edad Media. Ejercieron de escribas, traductores y guardianes, sin pensar, aparentemente, en crear su propia ciencia.

sucinta, sin más explicaciones. Es una idea que se formuló por primera vez en Alemania hace unos 150 años y que, poco a poco, ha ido calando, sutilmente en nuestras consciencias a través de la educación que, la única concesión que se hace a las culturas no europeas es la que se refiere al Islam. Esta teoría dice que los árabes conservaron viva la cultura griega, incluida la ciencia, durante toda la Edad Media. Ejercieron de escribas, traductores y guardianes, sin pensar, aparentemente, en crear su propia ciencia.

Al Sur de la puerta de Almodóvar de Córdoba, se levanta la estatua de Averroes. Jurista, médico, filósofo. El gran Averroes fue la máxima autoridad judicial de la época,(siglo XII). Fue acusado por los fundamentalistas de poner la razón humana por encima de la ley divina. La mirada del viejo filósofo se pierde entre las callejas mientras escucha el murmullo del agua del estanque junto al que reposa.

las callejas mientras escucha el murmullo del agua del estanque junto al que reposa.

Nada de eso es cierto. De hecho, los eruditos islámicos admiraron y preservaron las matemáticas y la ciencia griega y actuaron como el hilo conductor de la ciencia de muchas culturas no occidentales, además de construir un edifcio propio impresionante en el campo de las ciencias. Lo cierto es que, la ciencia occidental es lo que es porque se construyó acertadamente sobre las mejores ideas de los distintos pueblos, los mejores datos e incluso, los mejores aparatos procedentes de otras culturas. Por ejmplo, los babilonios desarrollaron el teorema de Pitágoras (la suma de los cuadrados de los dos lados perpendiculares de un triángulo rectángulo es igual al cuadrado de la hipotenusa) al menos mil quinientos años antes de que Pitágoras naciera.

e incluso, los mejores aparatos procedentes de otras culturas. Por ejmplo, los babilonios desarrollaron el teorema de Pitágoras (la suma de los cuadrados de los dos lados perpendiculares de un triángulo rectángulo es igual al cuadrado de la hipotenusa) al menos mil quinientos años antes de que Pitágoras naciera.

En el año 200 d. C., el matemático chino Liu Hui calculó para el número π un valor (3,1416) que se mantuvo como la estimación más precisa de dicho número durante unos mil años. Nuestras cifras del 0 al 9, se inventaron en la antigua India, siendo las cifras de Gwalior del año 500 d. C. casi indistinguibles de las cifras occidentales modernas. Álgebra es una palabra árabe que significa “obligación”, como cuando se obliga a que la incógnita x tome un valor numérico.

π un valor (3,1416) que se mantuvo como la estimación más precisa de dicho número durante unos mil años. Nuestras cifras del 0 al 9, se inventaron en la antigua India, siendo las cifras de Gwalior del año 500 d. C. casi indistinguibles de las cifras occidentales modernas. Álgebra es una palabra árabe que significa “obligación”, como cuando se obliga a que la incógnita x tome un valor numérico.

Arabia es una región de Oriente Medio del desierto comprendido entre el mar Rojo y el océano Índico. Desde el punto de vista histórico, esta región era conocida también como la cuna de una de las principales religiones del mundo, el Islam. Nacida en el siglo VII, esta religión había establecido importantes cambios en la configuración de mandato, los derechos económicos y principios culturales del mundo árabe. Sin embargo, pocos saben de su cultura y de la importante contribución que hicieron a la Ciencia (Astronomía, Medicina, Matemáticas…)

el punto de vista histórico, esta región era conocida también como la cuna de una de las principales religiones del mundo, el Islam. Nacida en el siglo VII, esta religión había establecido importantes cambios en la configuración de mandato, los derechos económicos y principios culturales del mundo árabe. Sin embargo, pocos saben de su cultura y de la importante contribución que hicieron a la Ciencia (Astronomía, Medicina, Matemáticas…)

China, Babilonia y también el Islam. El Califa árabe al-Mamun hizo construir la ciudad de la Sabiduría y un Observatorio para que los astrónomos pudieron observar las variantes de los parámetros astronómicos (obtenidos de los griegos) y las estrellas del cielo. Aportaron así la mayor contribución y uno de los valores más exactos de de la precesión de los equinoccios, la inclinación de la eclíptica y otros datos de este tipo. En el año 829 sus cuadrantes y sextantes eran mayores que los que construyó Tycho Brahe en Europa más de siete siglos después.

de este tipo. En el año 829 sus cuadrantes y sextantes eran mayores que los que construyó Tycho Brahe en Europa más de siete siglos después.

Como antes decía, en el siglo IX, el gran mecenas de la ciencia el califa abasí al-Mamun, reunió a varios astrónomos en Bagdad para crear la casa de la Sabiduría (Bait al-Hikmah). Allí los astrónomos llevaron a cabo observaciones del Sol y de la Luna, con el fin de determina la latitud y la longitud locales para fijar la gibla. Recopilaron algunos de los mejores resultados de un zij titulado “Lo Comprobado” (al-Mumtahan).

crear la casa de la Sabiduría (Bait al-Hikmah). Allí los astrónomos llevaron a cabo observaciones del Sol y de la Luna, con el fin de determina la latitud y la longitud locales para fijar la gibla. Recopilaron algunos de los mejores resultados de un zij titulado “Lo Comprobado” (al-Mumtahan).

Al-Biruni desarrolló técnicas para medir la Tierra y las distancias sobre ella utilizando la triangulación. Descubrió que el radio de la Tierra era 6.339,6 Kilómetros, un valor que no se obtuvo en Occidente hasta el siglo XVI. Uno de sus zijs contiene una tabla que da las coordenadas de seiscientos lugares, casi todos conocidos por él directamente.

En el año 499, Aryabhata escribió un pequeño volumen, Aryabhatuya, de 123 versos métricos, que se ocupaban de astronomía y (una tercera parte) de ganitapada o matemáticas. En la segunda mitad de esta obra, en la que habla del tiempo y la trigonometría esférica, Aryabhata utiliza una frase, en la que se refiere a los números empleados en el cálculo, “cada lugar es diez veces el lugar precedente”. El valor posicional había sido un componente esencial de la numeración babilónica, pero los babilonios no empleaban un sistema decimal.

lugar es diez veces el lugar precedente”. El valor posicional había sido un componente esencial de la numeración babilónica, pero los babilonios no empleaban un sistema decimal.

La fuerza de gravedad mantiene unidas las estrellas, estas a las galaxias, las galaxias entre sí, y, los mundos a las estrellas que orbitan, mientras nosotros, nos sentidos atraídos por la gravedad que genera el mundo que habitamos que mantiene nuestros pies unidos a la superficie impidiendo que flotemos sin control. (Tengo la suerte de que, Ken Crawford (Rancho Del Sol Obs.), me envíe imágenes como

sí, y, los mundos a las estrellas que orbitan, mientras nosotros, nos sentidos atraídos por la gravedad que genera el mundo que habitamos que mantiene nuestros pies unidos a la superficie impidiendo que flotemos sin control. (Tengo la suerte de que, Ken Crawford (Rancho Del Sol Obs.), me envíe imágenes como la de arriba).

la de arriba).

El Rig-veda (o Ṛgveda) es el texto más antiguo de la tradición védica; fue compuesto en sánscrito. Se trata de una colección de himnos compuestos en antiguo sánscrito védico, dedicados a las deidades. Se considera el más antiguo de los cuatro libros conocidos como Vedas.

Veinticinco siglos antes de Isaac Newton, el Rog-Veda hindú afirmaba que la gravitación hace que el universo se mantenga unido, aunque esta hipótesis era mucho menos rigurosa que la de Newton, en esencia, quería decir lo mismo que él dijo.

hipótesis era mucho menos rigurosa que la de Newton, en esencia, quería decir lo mismo que él dijo.

Sánscrito, lengua madre de la humanidad

Los arios de lengua sánscrita suscribieron la idea de que la Tierra era redonda en una época en que los griegos creían que era plana. Los hindúes del siglo V d. C. calcularon de algún modo la edad de la Tierra, cifrándola en 4.300 millones de años; los científicos ingleses del siglo XIX estaban convencidos de que la Tierra tenía 100 millones de años. Algunos expertos chinos del siglo IV d. C. -como los árabes del s. XIII y los papúes de Nueva Guinea posteriormente- adoptaron la rutina de utilizr fósiles para estudiar la historia del planeta, sin embargo, en el siglo XVII algunos miembros de la Universidad de Oxford seguían enseñando que los fósiles eran “pistas falsas sembradas por el diablo” para engañar a los hombres.

estudiar la historia del planeta, sin embargo, en el siglo XVII algunos miembros de la Universidad de Oxford seguían enseñando que los fósiles eran “pistas falsas sembradas por el diablo” para engañar a los hombres.

¡Que cosas!

Con todo esto, os quiero decir amigos míos que, cuando oímos hablar de la primacía europea con respecto a las Ciencias…, debemos dejar el comentario en cuarentena y, dedicar un tiempo a profundizar más en cómo fueron las cosas en la realidad. No siempre las cosas son como parecen, o, como nos las quieren presentar.

parecen, o, como nos las quieren presentar.

Mucho antes de que llegaran los científicos modernos, en tiempos del pasado muy lejano, otras culturas de filósofos naturales ya hablaban del átomo y del vacío. Ellos supieron intuir que había una materia cósmica y que todo lo grande estaba hecho de pequeñas cosas. Los pensadores de aquellos lugares eran anacoretas encerrados en un misticismo que los unía a la Naturaleza y a ese otro mundo de los pensamientos que están situados más allá de lo material. Ellos ya se preguntaban por…:

¡Tantas cosas!

Claro que, si no fuera tan largo de contar, os diría que, en realidad, el Higgs se descubrió hace ya muchos siglos en la antigua India, con el nombre de maya, que sugiere la idea de un velo de ilusión para dar peso a los objetos del mundo material. Pocos conocen que, los hindúes fueron los que más se acercaron a las ideas modernas sobre el átomo, la física cuántica y otras teorías actuales. Ellos desarrollaron muy temprano sólidas teorías atomistas sobre la materia. Posiblemente, el pensamiento atomista griega recibió las influencias del pensamiento de los hindúes a través de las civilizaciones persas. El Rig-Veda, que data de alguna fecha situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está realcionada con la luz cósmica.

situada entre el 2000 y el 1500 a. C., es el primer texto hindú en el que se exponen unas ideas que pueden considerarse leyes naturales universales. La ley cósmica está realcionada con la luz cósmica.

Anteriores a los primeros Upanishads tenemos en la India la creación de los Vedas, visiones poéticas y espirituales en las que la imaginación humana ve la Naturaleza y la expresa en creación poética, y después va avanzando unidades más intensamente reales que espirituales hasta llegar al Brahmán único de los Upanishads.

llegar al Brahmán único de los Upanishads.

la época de Buda (500 a, C.), los Upanishad, escritos durante un período de varios siglos, mencionaban el concepto de svabhava, definido “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia

un período de varios siglos, mencionaban el concepto de svabhava, definido “la naturaleza inherente de los distintos materiales”; es decir, su eficacia causal única, , tal como la combustión en el caso del fuego, o el hecho de fluir hacia abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

abajo en el caso dela agua. El pensador Jainí Bunaratna nos dijo: “Todo lo que existe ha llegado a existir por acción de la svabhava. Así… la tierra se transforma en una vasija y no en paño… A partir de los hilos se produce el paño y no la vasija”.

También aquellos pensadores, manejaron el concepto de yadrccha, o azar desde tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

tiempos muy remotos. Implicaba la falta de orden y la aleatoriedad de la causalidad. Ambos conceptos se sumaron a la afirmación del griego Demócrito medio siglo más tarde: “Todo lo que hay en el universo es fruto del azar y la necesidad”. El ejemplo que que dio Demócrito -similar al de los hilos del paño- fue que, toda la materia que existe, está formada por a-tomos o átomos.

Bueno, no lo puedo evitar, mi imaginación se desboca y corre rápida por los diversos pensamientos que por la mente pasan, de uno se traslada a otros y, al final, todo resulta un conglomerado de ideas que, en realidad, quieren explicar, dentro de esa diversidad, la misma cosa.

Emilio Silvera Vázquez

PD. Los datos provienen de fuentes variadas.

provienen de fuentes variadas.

Oct

16

El LHC al Servicio de la Salud

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en La Física y la Salud ~

Clasificado en La Física y la Salud ~

Comments (1)

Comments (1)

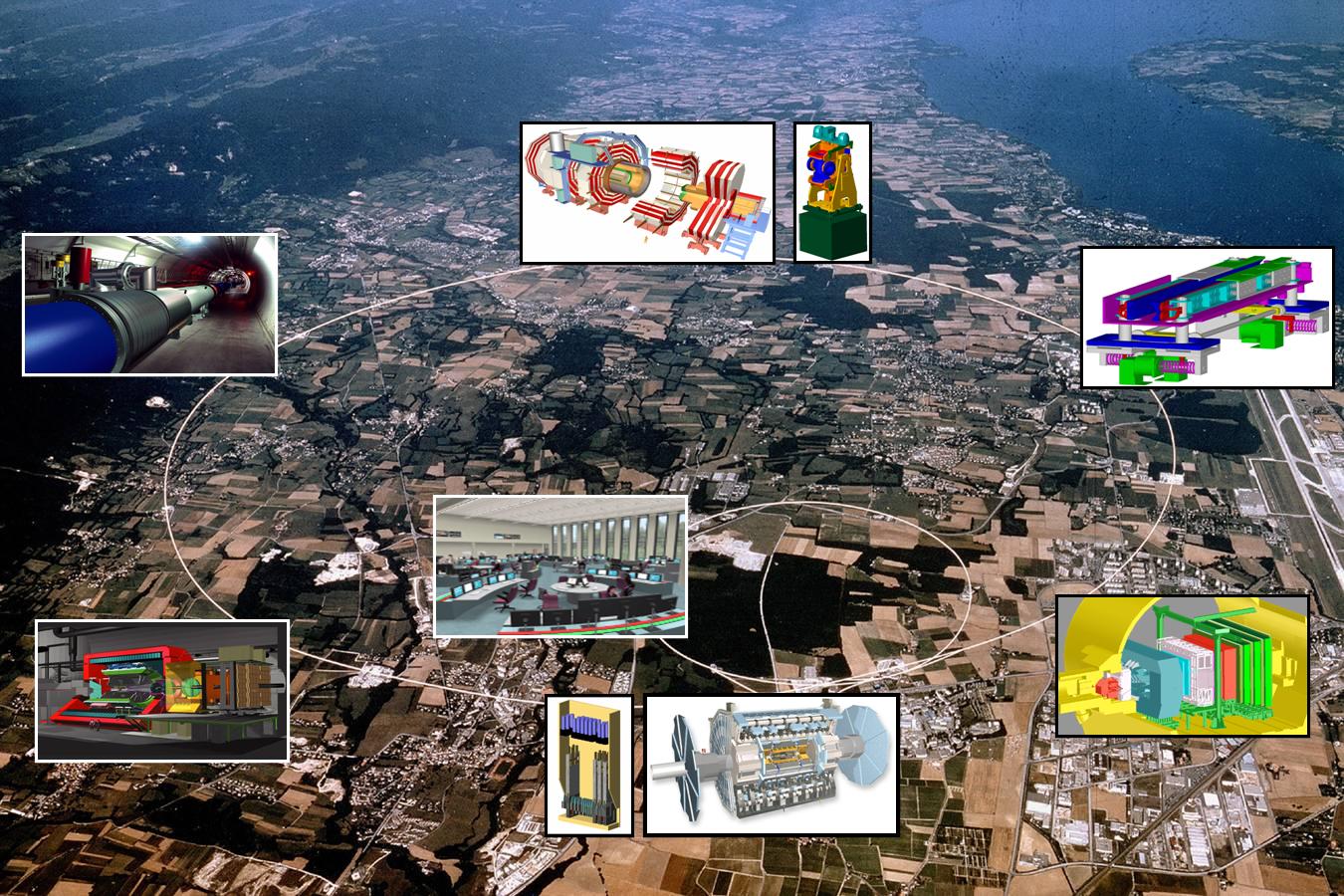

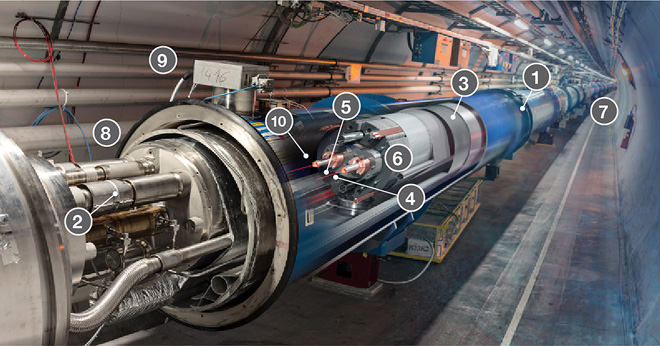

Partículas y mucho más

Los lectores de la Revista Española de Física han oído más de una vez hablar del CERN. Fundado en 1954, constituye el mayor laboratorio de física de partículas del mundo, con veinte países miembros y un personal de unas 3.000 personas entre físicos, ingenieros y personal técnico y administrativo de todo tipo. Seguramente están también al tanto de los grandes experimentos que se están preparando en este centro como el Large Hadron Collider (LHC), situado en un túnel circular de 27 km de longitud, destinado a elucidar el origen de la llamada ruptura de la simetría electrodébil y en última instancia el origen de las masas de las partículas elementales (no de la masa del protón o del neutrón como erróneamente se dice a veces en los medios de comunicación), o del proyecto CERN Neutrino Gran Sasso (CNGS), que consiste en enviar un haz de neutrinos de alta energía desde el CERN al laboratorio subterráneo italiano del Gran Sasso que se encuentra a 730 km, para estudiar las oscilaciones de estas huidizas partículas.

También es muy probable que muchos lectores asocien de manera natural la palabra acelerador de partículas a los instrumentos que utilizan los físicos modernos para estudiar y comprender mejor la estructura y el comportamiento de la materia a pequeñas escalas. Sin embargo, de los 17.000 aceleradores de partículas que se estima existen en la actualidad en todo el mundo, aproximadamente la mitad de ellos se usan en medicina y sólo una parte muy pequeña se usan para investigación fundamental. Por este y otros motivos que se discutirán más adelante, en este número especial de la Revista Española de Física dedicado a la física y las ciencias de la vida, ha parecido conveniente incluir un artículo en el que, al menos brevemente, se describieran algunas de las transferencias tecnológicas (spinoffs) importantes que la actividad del CERN aporta a dichas ciencias.

Mucho de lo que aquí se descubre, se aplica a nuestra Salud

Es bastante razonable que, como ocurre con las ciencias del espacio, mucha gente se pregunte cuál es la utilidad social de la física de partículas más allá de la adquisición de conocimientos fundamentales de la naturaleza. Sin embargo, es preciso señalar que los aceleradores y detectores de partículas del CERN y otros laboratorios similares requieren el uso, y muchas veces el desarrollo, de tecnologías de punta que obligan a una estrecha colaboración con la industria que redunda en beneficio de ambas partes. Las transferencias tecnológicas que se producen en este proceso se incorporan inmediatamente a nuestra vida diaria en áreas tales como la electrónica, procesamiento industrial y médico de imágenes, manejo y usos de la radiación , metrología, nuevos materiales, tecnologías de la computación y la información, tratamiento del cáncer, etc. En este artículo se pondrá el énfasis en aquellas actividades del CERN que han redundado de una forma más clara en beneficio de las ciencias biomédicas.

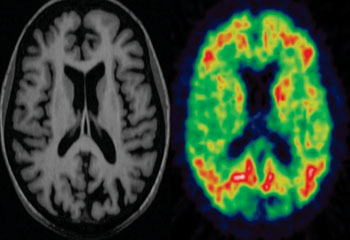

PET/TC o más allá de los rayos X

- ¿Qué es una exploración por tomografía por emisión de positrones/tomografía computarizada (PET/TC)?

- ¿Cuáles son algunos de los usos comunes del procedimiento?

- ¿Cómo debo prepararme para una exploración PET y PET/TC?

- ¿Cómo es el equipo?

- ¿Cómo funciona el procedimiento?

- ¿Cómo se realiza?

- ¿Qué experimentaré durante y después del procedimiento?

- ¿Quién interpreta los resultados y cómo los obtengo?

- ¿Cuáles son los beneficios y los riesgos?

- ¿Cuáles son las limitaciones de la tomografía por emisión de positrones – tomografía computada (PET/TC)?

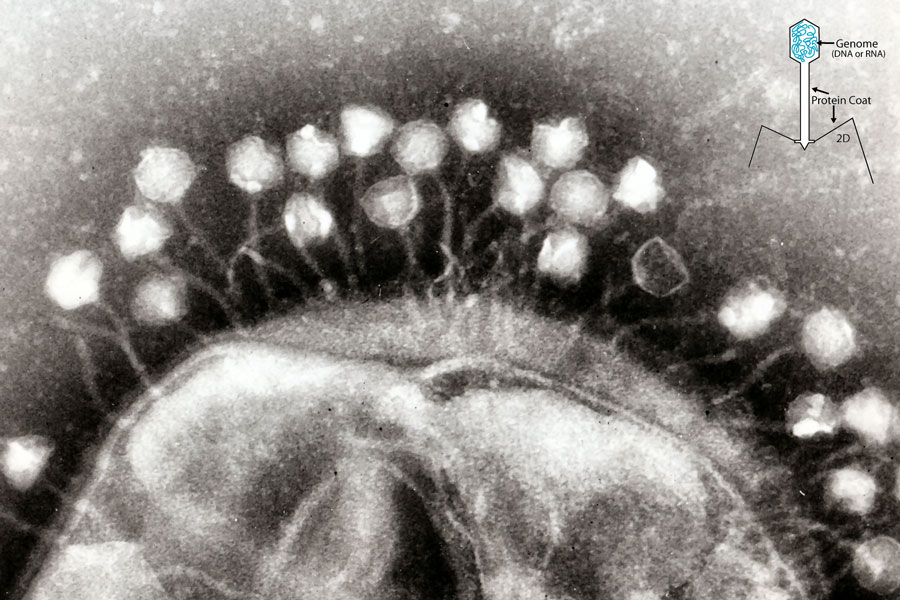

En el ámbito de la medicina los aceleradores de partículas se utilizan con dos finalidades; una para la formación de imágenes con propósitos diagnósticos y otra, para terapia, principalmente oncológica. Desde el descubrimiento de los rayos X por Röntgen en 1895, este tipo de radiación electromagnética ha proporcionado una información de valor incalculable y aún sigue proporcionándola. Sin embargo, mucho más recientemente, se han desarrollado otras técnicas complementarias de diagnóstico basadas en los llamados radiofármacos. Estas sustancias radiactivas presentan idealmente la propiedad de poder ser inyectadas en el organismo humano de forma segura y de fijarse exclusivamente a determinados tejidos. Posteriormente, a medida que van desintegrándose, emiten ciertas partículas que pueden ser detectadas y analizadas produciendo de esta forma imágenes estáticas o incluso dinámicas de los órganos en los que se depositaron los radiofármacos y, en definitiva, proporcionando información no solamente sobre la morfología de aquellos, sino también, en muchos casos, sobre su función y metabolismo.Los radiofármacos se producen utilizando haces de protones de alta intensidad y, como tienen una vida media muy baja, deben utilizarse cerca de donde se han creado. Se calcula que unos 20 millones de personas son diagnosticadas cada año mediante el uso de este tipo de sustancias.

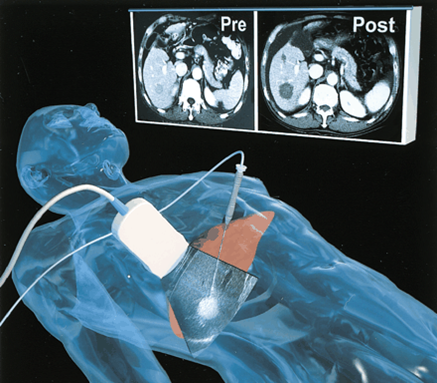

Son técnicas no invasivas que dejan al descubierto lo que interesa ver y eliminar

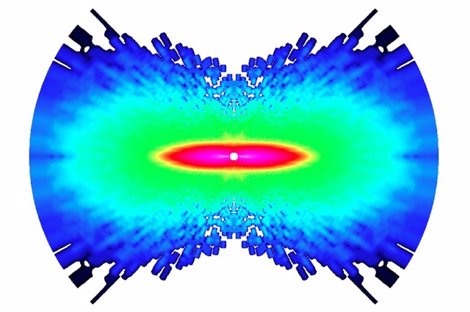

Una de las técnicas de este tipo más utilizada en la actualidad es la Positron Emission Tomography (PET). En su aplicación se utiliza normalmente un ciclotrón para irradiar alguna sustancia que se convierte en radiactiva por desintegración beta positiva (emisora de positrones). Esta sustancia se une por ejemplo a la glucosa y se inyecta al paciente. Los positrones producidos se aniquilan con los electrones circundantes dando lugar a dos fotones de energía muy bien definida, emitidos en direcciones opuestas. Estos fotones interaccionan con un material escintilador dando lugar a la emisión de otros fotones que pueden ser detectados por fotomultiplicadores o fotodiodos para formar la imagen de los tejidos que se pretenden estudiar en función de la distribución de la glucosa radiactiva. Por ejemplo, en el caso del diagnóstico del cáncer las células cancerosas suelen consumir más glucosa que las células sanas debido a su mayor vascularización y a su mayor actividad metabólica y reproductiva, produciendo por tanto una mayor emisión de fotones. Por el contrario, las zonas donde el tejido presente mayor número de células muertas brillarán menos debido a la menor concentración de glucosa radioactiva, lo cual puede ser muy útil para el diagnóstico de infartos y otras lesiones.

Nuevas tecnologias que llegan más lejos

De acuerdo con David Townsend, uno de los pioneros en el desarrollo de la tecnología PET, aunque ésta no fue inventada en el CERN, una cantidad esencial e inicial de trabajo desarrollado en el CERN a partir de 1977 contribuyó de forma significativa al desarrollo del PET 3D. La tecnología PET alcanza su grado más alto de utilidad diagnóstica cuando se combina con la Computed Tomography (CT). La CT es un método de formación de imágenes tridimensionales a partir del procesamiento digital de un gran número de imágenes bidimensionales de rayos X. Inicialmente, las diferentes imágenes se obtenían alrededor de un solo eje de rotación y de ahí su nombre original de Computed Axial Tomography (CAT).

La técnica combinada PET/CT es uno de los desarrollos más excitantes de la medicina nuclear y la radiología modernas. Las reconstrucciones de imágenes CT permiten el diagnóstico precoz de tumores basándose en sus características morfológicas, mientras que la tecnología PET es capaz de diferenciar con grane eficiencia los tejidos malignos de los benignos. La fusión PET/CT permite ahora integrar las imágenes morfológica y fisiológica en una única imagen. El prototipo del scanner ART, el Partial Ring Tomograph (PRT), fue desarrollado en el CERN en 1980 y 1990 por David Townsend, Martín Wensveen y Henri Tochon-Danguy, y evaluado clínicamente en el departamento de medicina nuclear del Hospital Cantonal de Ginebra. ART puede considerarse como el precursor de la parte PET del moderno scanner PET/CT, que ha producido un impacto extraordinario en la tecnología de imágenes con fines médicos. Además, el CERN continua hoy en día contribuyendo a este campo fundamental de la medicina moderna mediante proyectos como Clear PET, Clear PEM, HPD PET etc.

Sin embargo, la importancia del CERN en el desarrollo de las tecnologías PET o CT, y en general de todo tipo de scanner, va mucho más allá. En efecto, todo este tipo de dispositivos se basa, de una forma u otra, en los detectores desarrollados a finales de los sesenta en el CERN por George Charpak. Su trabajo fue reconocido en 1992 con la concesión del Premio Nobel de Física por su invención y desarrollo de detectores de partículas, en particular de la cámara proporcional multihilos, que produjo una revolución en la técnica de exploración de las partes más íntimas de la materia. Los detectores desarrollados por Charpak se usan aún para todo tipo de investigaciones médicas y biológicas y podrían eventualmente sustituir completamente a las placas fotográficas en la radio-biología aplicada. La velocidad creciente con la que permiten registrar las imágenes en radio medicina conducen a una menor tiempo de exposición y a menores dosis de radiación indeseada recibida por los pacientes.

Hadrón-terapia, o las partículas contra el cáncer

Como es bien sabido, una de las herramientas terapéuticas esenciales en el campo de la oncología es la radioterapia. Dicho tratamiento se aplica hoy en día aproximadamente a la mitad de los pacientes de cáncer. En cierto modo se puede considerar como una forma sutil de cirugía donde el bisturí es reemplazado por un haz colimado de partículas capaz de esterilizar las células malignas mediante la inactivación de su ADN, impidiendo así su reproducción. Tradicionalmente, la radioterapia se ha basado en el uso de rayos X (fotones), electrones y, más recientemente, hadrones, es decir, partículas capaces de interaccionar fuerte o nuclearmente, si bien no es ésta la propiedad más interesante de estas partículas para las aplicaciones radioterapeúticas. Los haces de rayos X y los electrones se obtienen normalmente a partir de aceleradores lineales como los del CERN, aunque mucho más pequeños, y se apuntan hacia los tumores con la energía, dirección y colimación apropiadas para optimizar su efecto destructivo sobre los mismos. Por su parte, los neutrones pierden energía en el interior del organismo de una forma diferente, lo cual les hace más indicados para el tratamiento de ciertos tipos especiales de tumores. Se obtienen a partir de las colisiones de protones, previamente acelerados en un ciclotrón, con núcleos de berilio. Este hecho hace que esta terapia sea bastante más cara que las anteriores, pero a cambio el ciclotrón puede ser usado también para la producción de radiofármacos.

i Científicos del CERN aplican antimateria contra el Cáncer

El estudio de las posibilidades de utilización de haces de hadrones en la terapia del cáncer tuvo su origen en el trabajo seminal de R.R Wilson titulado Radiological Use of Fast Protons (Radiology 47, 1946). En dicho artículo se ponía de manifiesto que los protones, así como otras partículas cargadas pesadas, presentan la propiedad única de que al penetrar en el cuerpo humano depositan la mayor parte de su energía a una preofundidad que depende de su energía inicial. Este hecho permite seleccionar cuidadosamente el área que se quiere irradiar, preservando de dicha radiación al tejido sano que pudiera encontrarse a menor profundidad. Además, como las partículas se detienen a una distancia de la superficie bien definida por la energía del haz, tampoco resultarían dañadas las células situadas detrás del blanco seleccionado.

En contraste, la energía depositada por los rayos X alcanza su máximo cerca de la superficie de entrada y decae exponencialmente hasta que abandona el cuerpo humano en el lado opuesto, haciendo por tanto muy difícil seleccionar la zona que quiere irradiarse sin dañar otras áreas de células sanas. El trabajo de Wilson de 1946 condujo a toda una nueva línea de investigación experimental, principalmente en el Lawrence Berkeley Laboratory, que ha dado lugar al desarrollo de una nueva clase de terapias antitumorales basadas en la irradiación con protones y más recientemente con iones de carbono. Estas técnicas han sido aplicadas en más de 40 centros de todo el mundo, y de ellas se han beneficiado hasta la fecha más de 50.000 pacientes. No obstante, continúan investigándose nuevas formas de intentar mejorar el ratio entre la energía depositada en las células tumorales y en el tejido sano.

Hidroterapia

En la actualidad, el CERN se encuentra involucrado en diversos proyectos relacionados con la hadrón-terapia. Por ejemplo, en el diseño de un acelerador de protones e iones de carbono dedicado exclusivamente a usos médicos conocido como Proton Ion Medical Machine Study (PIMMS). Otro proyecto interesante es la realización de las pruebas del Linear Booster ( LIBO), capaz de acelerar una haz de protones hasta 200 Mev (los hospitales habiualmente utilizan energías en torno a los 65 MeV) y que estaría especializado en el tartamiento de tumores profundos.

Finalmente, y situándonos en un plano de investigación a un nivel más básico, es interesante señalar que en octubre de 2006 se presentaron los primeros resultados de un experimento llevado a cabo en el CERN con potencial para futuras aplicaciones en la terapia del cáncer. Se trataba del Antiproton Cell Experiment (ACE), que constituye la primera investigación realizada hasta la fecha sobre efectos biológicos de los antiprotones. Los antiprotones se comportan como los protones cuando entran en el organismo, pero generan mucha más energía en el blanco seleccionado debido a du aniquilación con los protones existentes en los núcleos de los átomos de las células, y además depositan esta energía de una forma biológicamente más efectiva.

Cómo la antimateria permite diagnosticar cáncer

Se busca antimateria contra el Cáncer. Los resultados muestran que los antiprotones son cuatro veces más efectivos que los protones para destruir células vivas. (Foto: Especial CERN )

Evaluando la fracción de células supervivientes después de la irradiación con el haz de antiprotones, el experimento ACE ha encontrado que a eficiencia de éstos es unas cuatro veces mayor que la de los protones, mientras que el daño producido a las células situadas antes del blanco era básicamente el mismo. De acuerdo con Michael Holzscheiter, portavoz del experimento ACE, este hecho podría ser extremadamente importante para el tratamiento de casos de cáncer recurrente, donde este tipo de propiedad es vital. La tecnología desarrollada previamente en el CERN para la obtención de haces de antiprotones de buena calidad a la energía apropiada es esencial para este prometedor experimento, que difícilmente podría haberse realizado en ningún otro laboratorio. Éste es por tanto un magnífico ejemplo de cómo la investigación en física de partículas desarrollada en el CERN puede generar soluciones innovadores con excelentes beneficios médicos potenciales.

Los investigadores de ACE, en colaboración con otras instituciones de todo el mundo, están realizando en la actualidad nuevos tests para comprobar la eficacia de este método en el caso de tumores situados a mayor profundidad, y comparando sus resultados con los de otros métodos más convencionales como la irradiación mediante iones de carbono. Si todo sale como se espera, los beneficios clínicos de esta nueva técnica podrían empezar a producirse dentro de la próxima década.

No es un metal precioso ni un diamante ni un mineral estratégico… Es la antimateria, la otra cara (invisible) de la materia común. Sus cualidades son extraordinarias. Ya la usamos para detectar células cancerosas y servirá para destruirlas sin dañar los tejidos sanos. Y puede ser el combustible del futuro. Con solo diez miligramos una nave llegaría a Marte. El problema es que producir un solo miligramo de antimateria cuesta 57.000 millones de euros. Y el precio no es el único inconveniente…

Otro ejemplo importante de tecnología creada en el CERN con aplicaciones a la terapia del cáncer es el Neutron Driven Element Trasmuter. Se trata de un sistema de producción de radioisótopos específicos específicos a partir de un acelerador de protones cuyo desarrollo fue liderado por Carlo Rubbia, Premio Nobel de Física en 1984 por el descubrimiento de los bosones W y Z y ex director general del CERN. La idea es utilizar el haz de protones para producir neutrones los cuales provocan reacciones en un ambiente apropiado donde ciertos elementos son convertidos en los isótopos deseados.

La diferencia principal entre este método, seguro y barato, y el método más tradicional de utilizar los neutrones provenientes de un reactor nuclear, es que no requiere el uso de material fisionable ni funciona críticamente, es decir las reacciones se detienen en el momento en el que el acelerador es apagado. Más aún, el método tiene la ventaja de que sólo se producen los isótopos requeridos, lo que redunda en una importante reducción de impacto ambiental. Normalmente, el blanco utilizado es plomo, elemento idóneo por presentar el menor ritmo de captura de neutrones. Los neutrones se producen por espalación a partir del haz de protones y permanecen en el interior del blanco de plomo, que está rodeado de un deflector de grafito, hasta que su espectro se suaviza suficientemente para cubrir un gran rango de energías que permiten su utilización para la transmutación de los elementos necesarios para la obtención de los isótopos deseados.

El Neutron Driven Element Trasmuter ha permitido, entre otras cosas, la producción de radioisótopos beta emisores como el 166Ho, 186 Re o el 188Re que son de gran importancia en braquiterapia. Dicha técnica, muy utilizada en el tratamiento de cánceres ginecológicos y en el de cáncer de próstata, es un tipo de radioterapia de proximidad donde la fuente radiactiva se sitúa dentro o muy cerca de los tejidos que requieren irradiación. Típicamente, la fuente radiactiva, de alta actividad y corta vida media, se encapsula en una semilla, filamento o tubo y se implanta en quirófano en la zona deseada. Las diferentes dosis requeridas en cada caso hacen que sea fundamental disponer del mayor muestrario posible de radioisótopos con la actividad y vida media apropiadas, lo cual convierte al Neutrón Driven Element Trasmuter en una herramienta valiosísima para el futuro de este tipo de técnica terapéutica.

Información y computación sin fronteras

CERN, … where the web was born; éste es uno de los reclamos publicitarios que suelen utilizarse para hacer ver al público la importancia de los retornos tecnológicos que en este laboratorio tienen lugar. Y en efecto, fue a finales de los ochenta cuando Tim Berners-Lee desarrolló estándar de Hyper Text Transfer Protocol (HTTP) e implementó los primeros servidores web en el CERN. Su esfuerzo permitió la comunicación fácil y segura y el intercambio de todo tipo de información entre todos los ordenadores del mundo conectados a internet, dando lugar de esta forma a una de las revoluciones tecnológicas más importantes de las últimas décadas. Las repercusiones científicas, tecnológicas, culturales, comerciales y de ocio de la web son ya tan conocidas que apenas merecen comentario alguno.

El término Grid fue acuñado por Ian Foster and Carl Kesselman en su libro The Grid, Blueprint for new Computing Infraestructure (Morgan Kaufman, 1998), aunque las ideas básicas habían sido consideradas con anterioridad. No existe un acuerdo general sobre cual debería ser la definición precisa de las tecnologías Grid, pero hay un amplio concenso en que esta debería contener elementos tales como recursos compartidos, virtualización, abstracción del acceso a los recursos y estandarización. La filosofía Grid consistería, no sólo en compartir información entre diferentes usuarios, sino también recursos, como por ejemplo, procesadores, tiempo de CPU, unidades de almacenamiento, así como otros aparatos e instrumentos, de tal forma que eventualmente cada usuario tendría acceso virtual, por ejemplo, a la capacidad de cálculo de todos los demás usuarios de esa Grid. En los primeros tiempos de esta tecnología de la información se llegó a hablar de la Grid, refiriéndose a la posibilidad de existencia de una única World Wide Grid.

Todo surgió del CERN

Hasta el momento,, sin embargo, este concepto no es una realidad y más bien lo que se encuentra es que diferentes grupos de proyectos crean su propia Grid usando sus propias implementaciones, estándares y protocolos y dando acceso restringido solamente a una cierta comunidad de usuarios autorizados. Así, aunque se siguen realizando importantes esfuerzos en cuanto a la estandarización de los protocolos, no está claro cual será el camino que este tipo de tecnología seguirá en el futuro en lo que se refiere a la futura existencia de un única Grid.

En cualquier caso es importante resaltar que una vez más el CERN ha sido pionero en este tipo de tecnología. Los detectores que se están instalando (a estas alturas, todos instalados y en marcha) en el LHC (ATLAS, CMS, ALICE, LHCb, SUSY, etc.), son tan complejos, que han requerido cada uno de ellos el concurso de muchas instituciones de todo el mundo para su construcción, y lo seguirán requiriendo para su mantenimiento cuando el acelerador empiece a funcionar (ya está en marcha), y, como no, para el análisis de los datos que se obtengan. Para hacerse una idea de la dimensión y complejidad de estos análisis baste mencionar que el compact Muon Selenoid (CMS), una vez pasado su primer filtro, deberá almacenar información sobre el resultado de las colisiones producidas en su interior a un ritmo del orden de 100 a 200 MB por segundo durante un tiempo esperado de unos cien días por año. Resulta obvio que sólo una tecnología tipo Grid puede afrontar con posibilidades de éxito un reto semejante y de hecho el CERN ha inspirado varios proyectos Grid multinacionales por este motivo. Posiblemente, el más grande de ellos hasta la fecha sea el EGEE (Enablinbg Grids for E-Science), que conecta más de 150 paises y ofrece 20 000 CPUs y más de 10 Petabytes de memoria.

![]()

De manera análoga a como ocurrió con las tecnologías de la detección y aceleración, las tecnologías Grid tendrán, y de hecho ya empiezan a tener, un fuerte impacto en las ciencias de la vida y de la salud. En este sentido, uno de los campos obvios de aplicación es la bioinformática. Gracias a los espectaculares avances llevados a cabo en los últimos años en el campo de la biología molecular, se dispone hoy en día de cantidades crecientes de información genética de diferentes especies e individuos. Dicha información codificada en el ADN en forma de secuencia de tripletes o codones de ácidos nucleicos, que constituyen los genes que contienen la estructura primaria de las diferentes proteínas, ha sido y está siendo obtenida por centenares de grupos diferentes distribuidos por todo el mundo y debe almacenarse en gigantescas bases de datos de forma eficiente para su compartición, contrastación y análisis.

Ejemplos típicos serían la búsqueda de determinadas secuencias, comparaciones, búsqueda de determinadas mutaciones o alelos, etc. Resulta evidente que esta ingente labor puede verse enormemente beneficiada por el uso de tecnologías Grid. De hecho, la Bioinformática, y en particular sus aplicaciones biomédicas, han sido una parte importante del proyecto EGEE desde el comienzo del mismo.

Finalmente, y como última muestra de cómo puede revertir en la sociedad las tecnologías de la información y la computación provenientes de la física de partículas, es interesante mencionar el Proyecto Mammogrid y su continuación Mammogrid Plus. Liderado por el CERN, dicho proyecto de la UE utiliza la tecnología Grid para crear una base de datos de mamografías que pueda ser usada para investigar un gran conjunto de datos e imágenes que, aparte de otras aplicaciones sanitarias, sea útil para estudiar el potencial de esta tecnología para servir de soporte a la colaboración entre los profesionales de la salud de la UE.

Ciencia, Tecnología y Sociedad

A estas alturas debería haber quedado claro que los centros científicos de élite internacionales como el CERN, no sólo nos proporcionan un conocimiento más profundo de la naturaleza, sino que las tecnologías de punta que en ellos se desarrollan acaban permeando a la Sociedad y se incorporan a nuestras vidas cotidianas. El autor del artículo, Antonio Dobado, del Departamento de Física Teórica I de la Universidad Complutense de Madrid, ha pretendido ilustrar el hecho innegable de la conexión existente entre temas tan aparentemente dispares como el de la Física de Partículas y la Biomedicina, pero ejemplos semejantes podrían haberse encontrado en prácticamente cualquier área de la actividad humana.

La Sociedad no puede permanecer por más tiempo ajena a la Ciencia y a todo lo que trae consigo. Precisamente por eso la RSEF dedica un gran esfuerzo a la difícil tarea de convencer al público de la importancia de la Física como valor científico, cultural y social, como una forma rigurosa y profunda del acercamiento al conocimiento de la naturaleza, y a la vez como generadora de nuevas tecnologías. En este sentido, es una espléndida noticia la inminente creación de un nuevo Grupo especializado en el seno de la RSEF denominado Física Médica. Y, desde aquí, aprovechamos la oportunidad para darles la bienvenida y desearles el mayor éxito en sus futuras andaduras en la búsqueda de la verdad científica.

Fuente: Revista Española de FÍSICA.

Oct

16

¿Qué será la materia?

por Emilio Silvera ~

por Emilio Silvera ~

Clasificado en Física ~

Clasificado en Física ~

Comments (4)

Comments (4)

¿Qué habrá en los Océanos de Higgs? ¡Si existen!

En primaria, nos decían que estaba en tres estados. Se profundizaba poco más y, el desconocimiento de la materia era grande: Sólido, Líquido y Gaseoso, esa era toda la explicación que sobre la materia nos daban.

En la física clásica y la química general, la materia se define como todo aquello que posee una masa, ocupa un volumen y es capaz de interactuar gravitatoriamente

Y, desde la materia “inerte” se evolucionó hasta alcanzar la consciencia de Ser ¿Cómo pudo ser?

Tiene y encierra tantos misterios la materia que estamos aún y años-luz de saber y conocer sobre su verdadera naturaleza. Nos podríamos preguntar miles de cosas que no sabríamos contestar. Nos maravillan y asombran fenómenos naturales que ocurren ante nuestros ojos pero que tampoco sabemos, en realidad, a que son debidos. Si, sabemos ponerles etiquetas como, por ejemplo, la fuerza nuclear débil, la fisión espontánea que tiene lugar en algunos elementos como el protactinio o el torio y, con mayor frecuencia, en los elementos que conocemos como transuránicos.

A medida que los núcleos se hacen más grandes, la probabilidad de una fisión espontánea aumenta. En los elementos más pesados de todos (einstenio, fermio y mendelevio), esto se convierte en el método más importante de ruptura, sobrepasando a la emisión de partículas alfa.

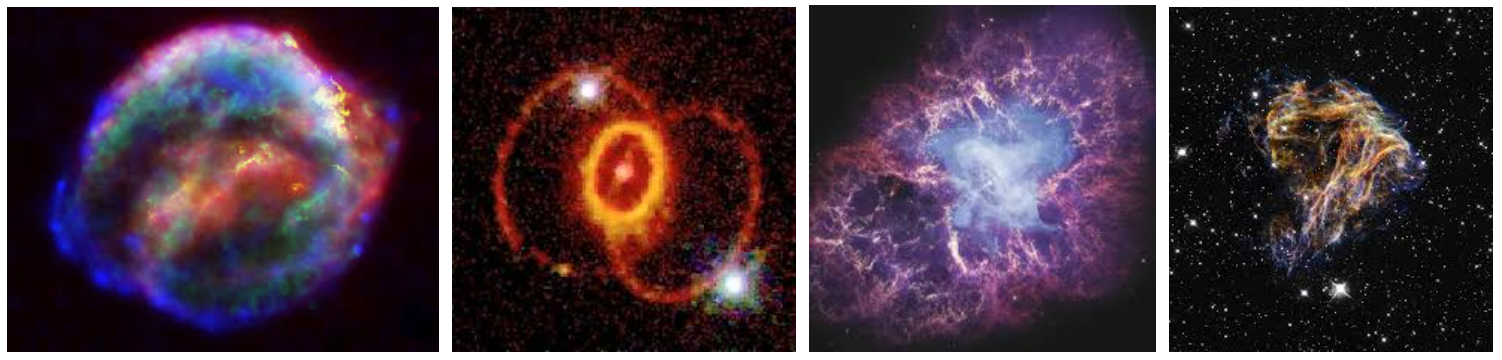

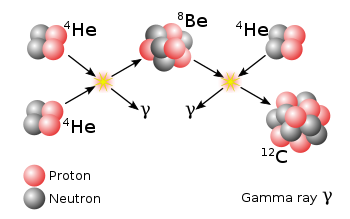

Maravillas como el proceso triple Alfa nos hace pensar que la materia está viva. La radiación ha sido muy bien estudiada y hoy se conocen sus secretos. Sin embargo, son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas.

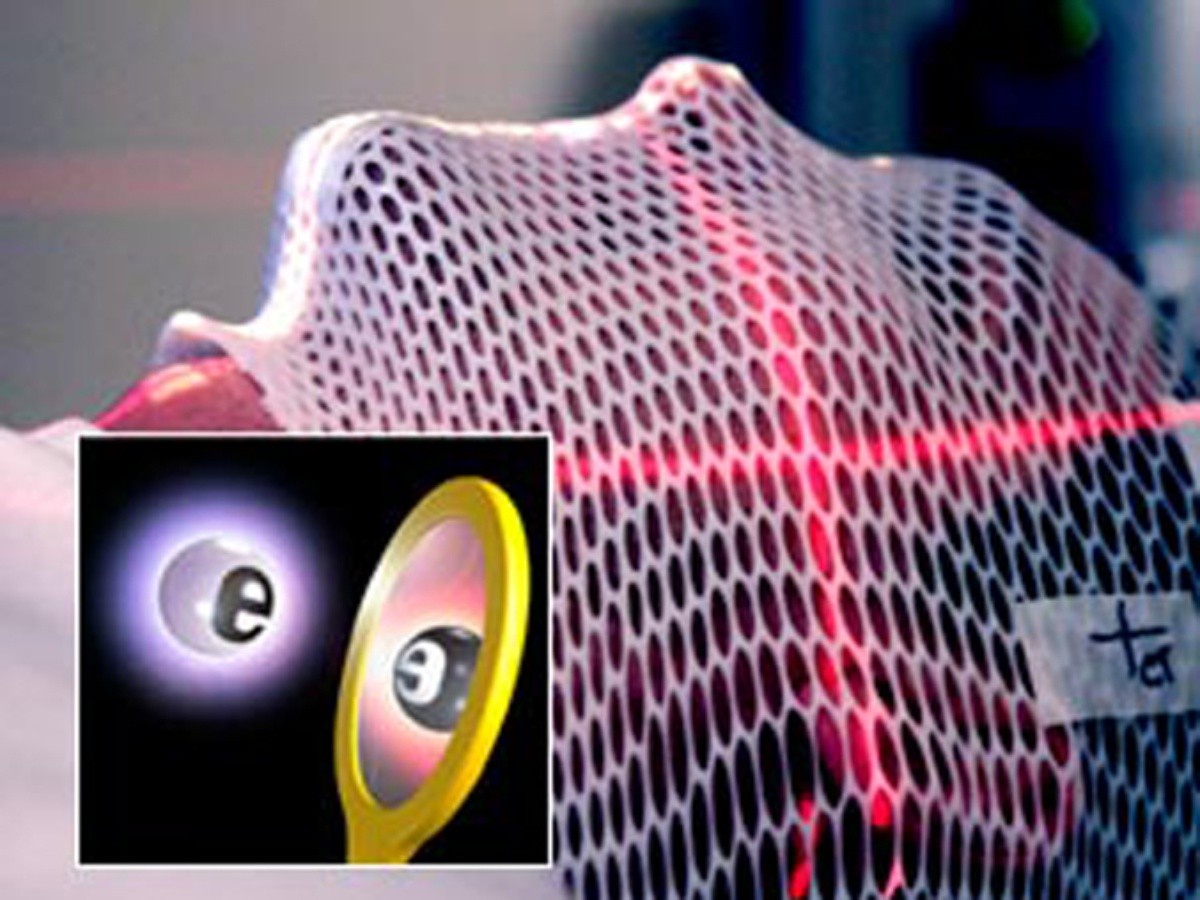

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

El electrón es onda y partícula

Aunque el electrón fue descubierto en 1.897 por el físico británico Josepth John Thomson (1856-1940), el problema de su estructura, si la hay, no está resuelto. Conocemos su masa y su carga negativa que responden a 9,1093897 (54)x10-31kg la primera y, 1,602 177 33 (49)x10-19 culombios, la segunda, y también su radio clásico. No se ha descubierto aún ninguna partícula que sea menos masiva que el electrón (o positrón) y que lleve una carga eléctrica, sea lo que fuese (sabemos como actúa y cómo medir sus propiedades, pero aun no sabemos qué es), tenga asociada un mínimo de masa, y que esta es la que se muestra en el electrón.

Lo cierto es que, el electrón, es una maravilla en sí mismo. El Universo no sería como lo conocemos si el electrón (esa cosita “insignificante”), fuese distinto a como es, bastaría un cambio infinitesimal para que, por ejemplo, nosotros no pudiéramos estar aquí ahora.

Son muchas las cosas que desconocemos y, nuestra curiosidad nos empuja continuamente a buscar esas respuestas. Me gustaría comprender lo que realmente es ese cuanto de energía que llamamos fotón y es el responsable de transmitir todas las formas de radiación que existen en nuestro Universo, la luz entre ellas, para que podamos ver lo que nos rodea y llegar a comprender.

El electrón y el positrón son notables por sus pequeñas masas (sólo 1/1.836 de la del protón, el neutrón, el antiprotón o antineutrón), y, por lo tanto, han sido denominados leptones (de la voz griega lepto que significa “delgado”).

Primeras imágenes de átomos en movimiento en una molécula

Investigadores de la Universidad Estatal de Ohio (Estados Unidos), han registrado, utilizando una nueva cámara ultrarrápida, la primera imagen en tiempo real de dos átomos vibrando en una molécula. La clave del experimento, que ha sido publicado en la revista ‘Nature’, fue la utilización de la energía del propio electrón de una molécula.

Función de onda de electrones

Previamente dos físicos de la Universidad Brown habían mostrado películas de electrones que se movían a través de helio líquido en el International Symposium on Quantum Fluids and Solids del 2006. Dichas imágenes, que mostraban puntos de luz que bajaban por la pantalla fueron publicadas en línea el 31 de mayo de 2007, en el Journal of Low Temperature Physics.

En el experimento que ahora nos ocupa y dada la altísima velocidad de los electrones el equipo de investigadores ha tenido que usar una nueva tecnología que genera pulsos cortos de láser de luz intensa (“Attoseconds Pulses”), habida cuenta que un attos-egundo equivalente a la trillonésima parte de un segundo”.)

Sin electrones no habría átomos, ni materia, ni vida

¡No por pequeño, se es insignificante! Recordémoslo, todo lo grande está hecho de cosas pequeñas. Las inmensas galaxias son el conjunto de muchos pequeños átomos unidos para formar moléculas que a su vez se juntan y forman cuerpos. Los océanos de la Tierra, las montañas de Marte, los lagos de metano de Titán, los hielos de Europa… ¡Todo está hecho de materia bariónica! Es decir, son pequeños Quarks y Leptones que conforman los átomos de lo que todo está hecho en nuestro Universo. Bueno, al menos todo lo que podemos ver.

Un “simple” átomo está conformado de una manera muy compleja. Por ejemplo, un protón está hecho de tres quarks: 2 up y 1 down. Mientras tanto, un neutrón está constituido de 2 quarks down y 1 quark up. Los protones y neutrones son hadrones de la rama barión, es decir, que emiten radiación. También son fermiones y, debido a su función en el átomo, se les suele llamar nucleones. Dichos quarks existen confinados dentro de los protones y neutrones inmersos en una especie de pegamento gelatinoso formado por unas partículas de la familia de los Bosones que se llaman Gluones y son los transmisores de la Fuerza nuclear fuerte. Es decir, si los quarks se quieren separar son atrapados por esa fuerza que los retiene allí confinados.

Louis de Broglie

Estudiar el “universo” de las partículas subatómicas es fascinante y se pueden llegar a entender las maravillas que nos muestra la mecánica cuántica, ese extraño mundo que nada tiene que ver con el nuestro cotidiano situado en el macromundo. En realidad, existen partículas que no tienen en absoluto asociada en ellas ninguna masa (es decir, ninguna masa en reposo). Por ejemplo, las ondas de luz y otras formas de radiación electromagnéticas se comportan como partículas (Einstein en su efecto fotoeléctrico y De Broglie en la difracción de electrones.)

Imagen ilustrativa de la dualidad onda-partícula, en el cual se puede ver cómo un mismo fenómeno puede tener dos percepciones distintas. Esta manifestación en forma de partículas de lo que, de ordinario, concebimos como una onda se denomina fotón, de la palabra griega que significa “luz”. Recientemente he podido leer que unos científicos han logrado (de alguna manera) “congelelar” la luz y hacerla sólida. Cuando recabe más información os lo contaré con todo detalle. El fotón, el cuanto de luz, es en sí mismo una maravilla.

El fotón tiene una masa de 1, una carga eléctrica de 0, pero posee un espín de 1, por lo que es un bosón. ¿Cómo se puede definir lo que es el espín? Los fotones toman parte en las reacciones nucleares, pero el espín total de las partículas implicadas antes y después de la reacción deben permanecer inmutadas (conservación del espín). La única forma que esto suceda en las reacciones nucleares que implican a los fotones radica en suponer que el fotón tiene un espín de 1. El fotón no se considera un leptón, puesto que este termino se reserva para la familia formada por el electrón, el muón y la partícula Tau con sus correspondientes neutrinos: Ve, Vu y VT.

Existen razones teóricas para suponer que, cuando las masas se aceleran (como cuando se mueven en órbitas elípticas en torno a otra masa o llevan a cabo un colapso gravitacional), emiten energía en forma de ondas gravitacionales. Esas ondas pueden así mismo poseer aspecto de partícula, por lo que toda partícula gravitacional recibe el nombre de gravitón.

La fuerza gravitatoria es mucho, mucho más débil que la fuerza electromagnética. Un protón y un electrón se atraen gravitacionalmente con sólo 1/1039 de la fuerza en que se atraen electromagnéticamente. El gravitón (aún sin descubrir) debe poseer, correspondientemente, menos energía que el fotón y, por tanto, ha de ser inimaginablemente difícil de detectar.

El gravitón parece estar riéndose de todos y no se deja ver. El gravitón es la partícula elemental responsable de la fuerza de la gravedad. Todavía no ha sido descubierto experimentalmente. Teóricamente debería tener masa en reposo nula. ¿Qué límites para la masa del gravitón ofrece el fondo cósmico de microondas? El gravitón es la partícula elemental responsable de la “versión” cuántica de gravedad. No ha sido descubierto aún, aunque pocos dudan de su existencia. ¿Qué propiedades tiene? Debe ser un bosón de espín 2 y como la gravedad parece ser una fuerza de largo alcance, debe tener masa en reposo muy pequeña (billones de veces más pequeña que la del electrón), posiblemente es exactamente cero (igual que parecer ser la del fotón).

Podría ser el descubrimiento más importante de la física de partículas desde los años 70”, ha proclamado la revista Nature en un editorial. Más importante, por lo tanto, que el bosón de Higgs. O que la docena de partículas descubiertas desde que se demostró la existencia de los quarks hace más de 40 años. El Gravitón es la próxima hazaña que será difícil de f8inalizar con éxito.